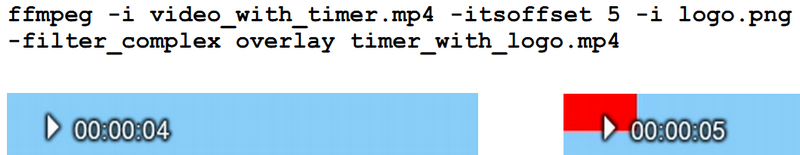

1. 画中画效果overlay滤镜

您现在的位置是:网站首页> 多媒体开发

FFMPEG系列知识集中地【视频加密】

- 多媒体开发

- 2025-09-05

- 8408人已阅读

FFMPEG系列知识集中地【视频加密】

ffmpeg 4.4版本对MP4文件进行AES-CTR加密,和流式加密

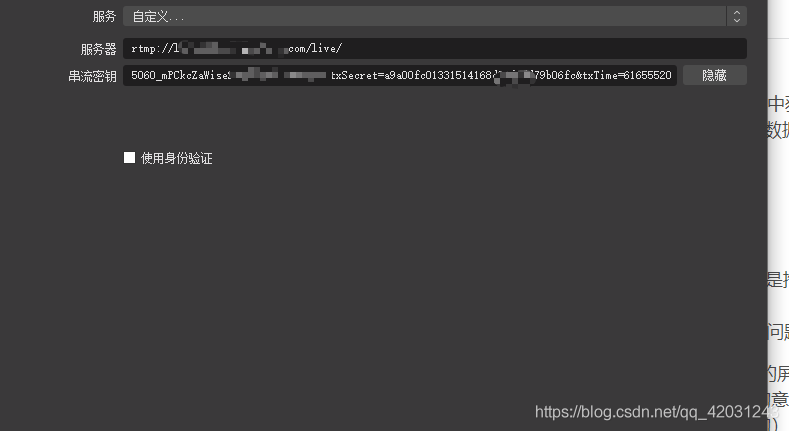

用ffmpeg+nginx+海康威视网络摄像头rtsp在手机端和电脑端实现直播

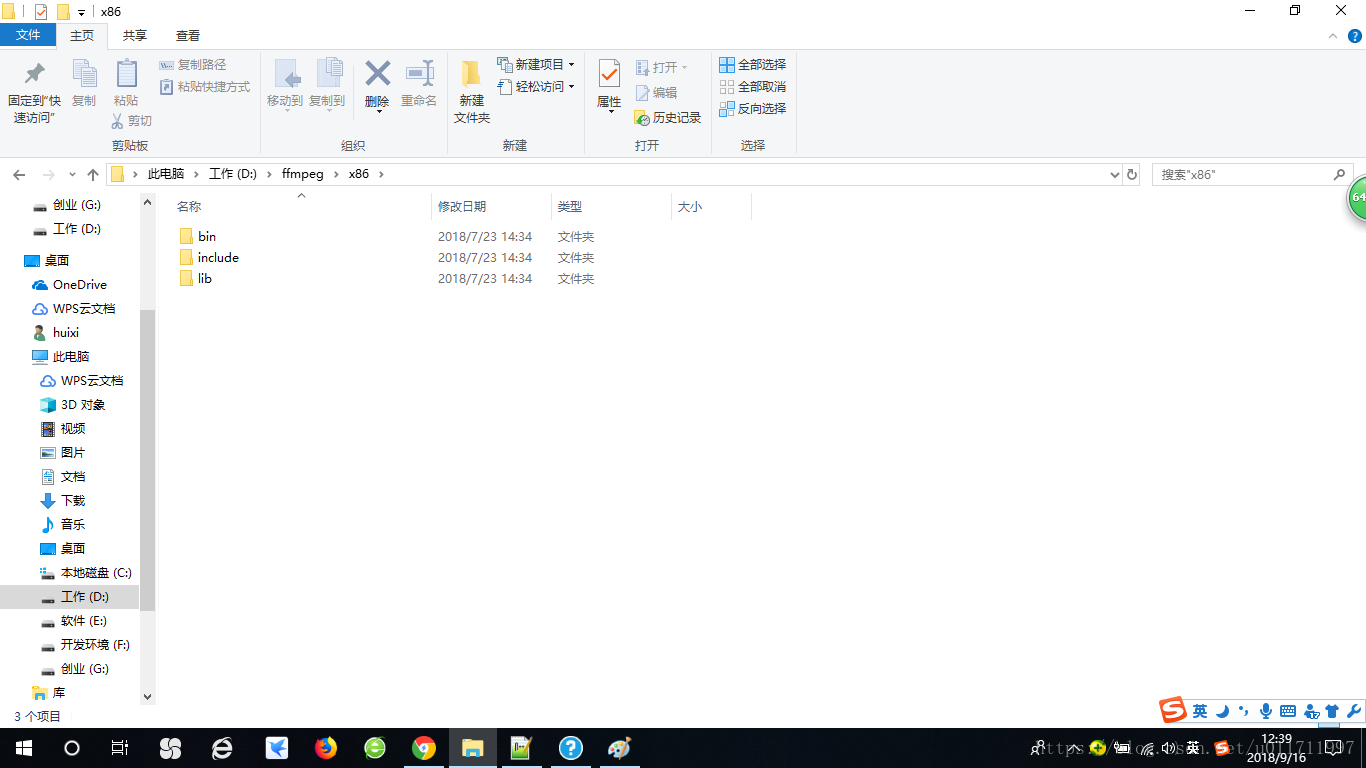

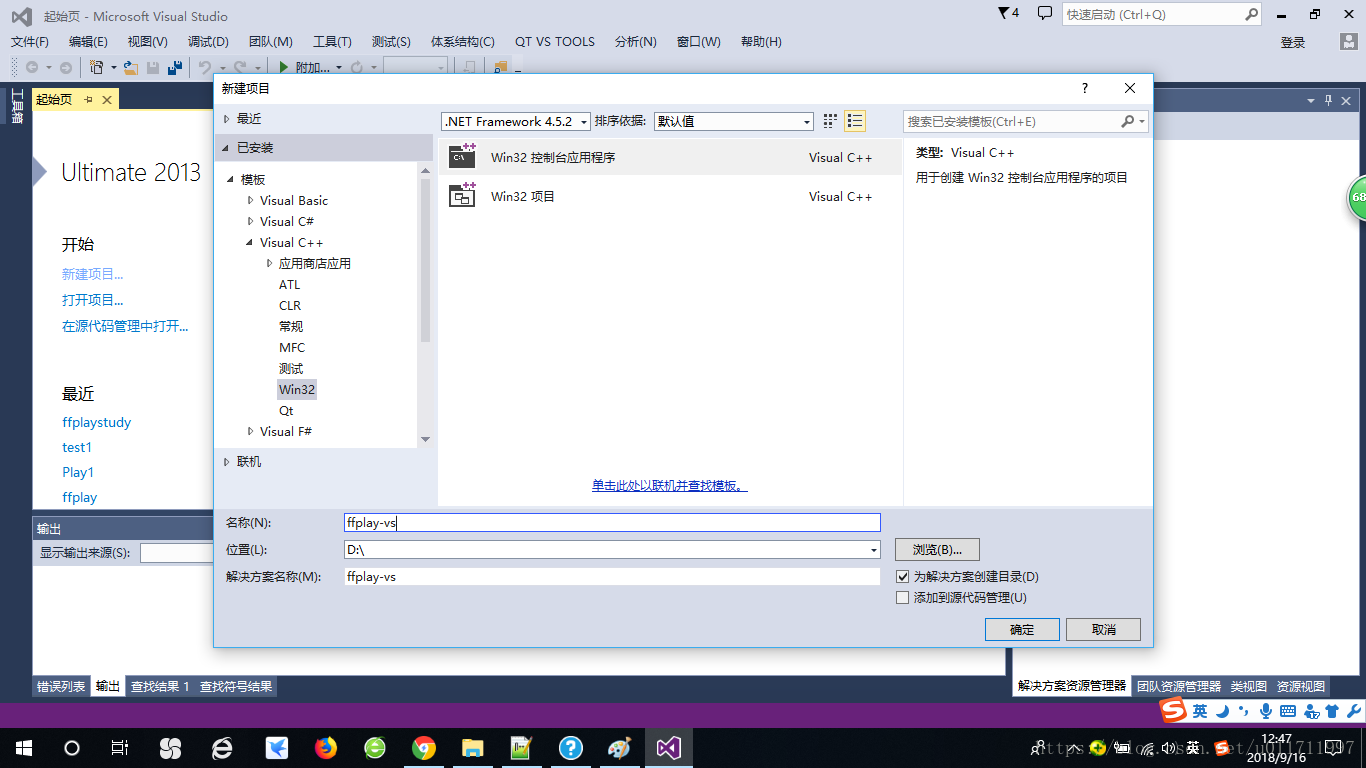

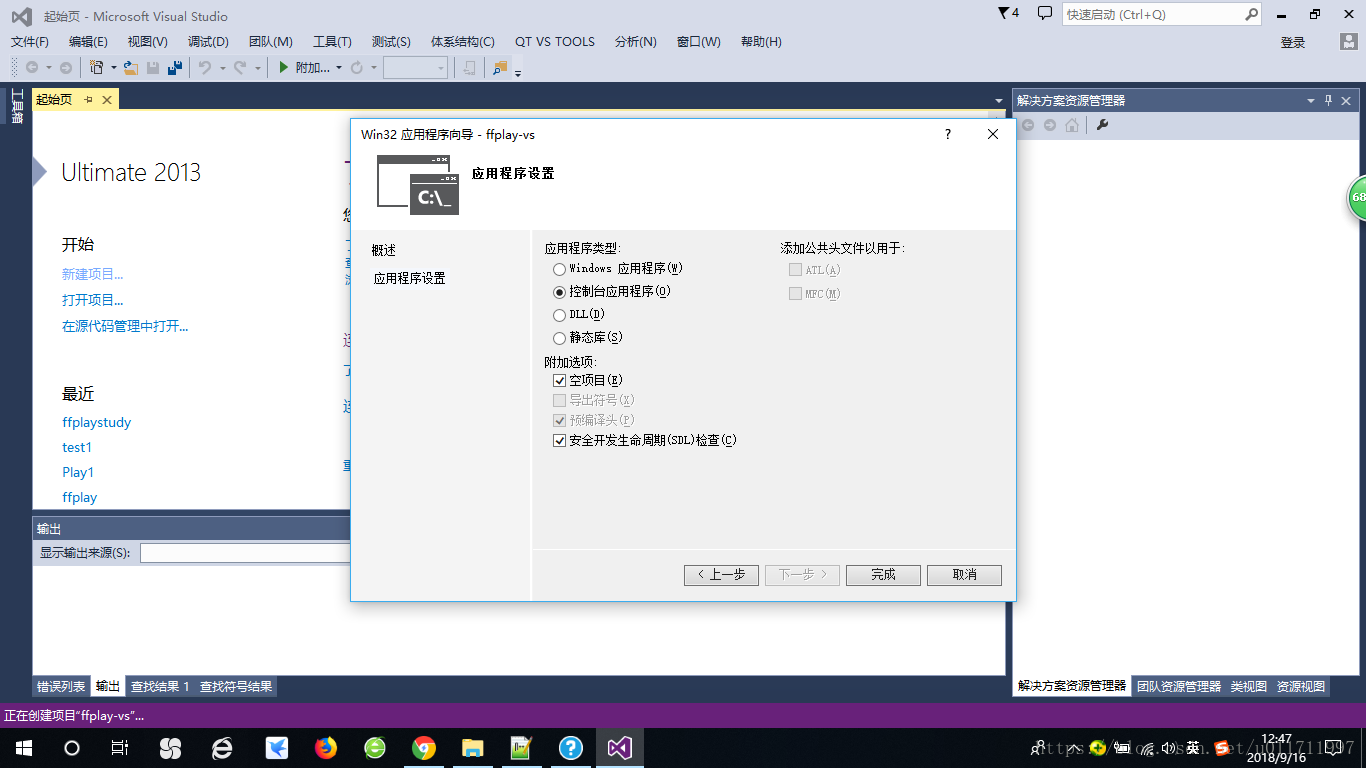

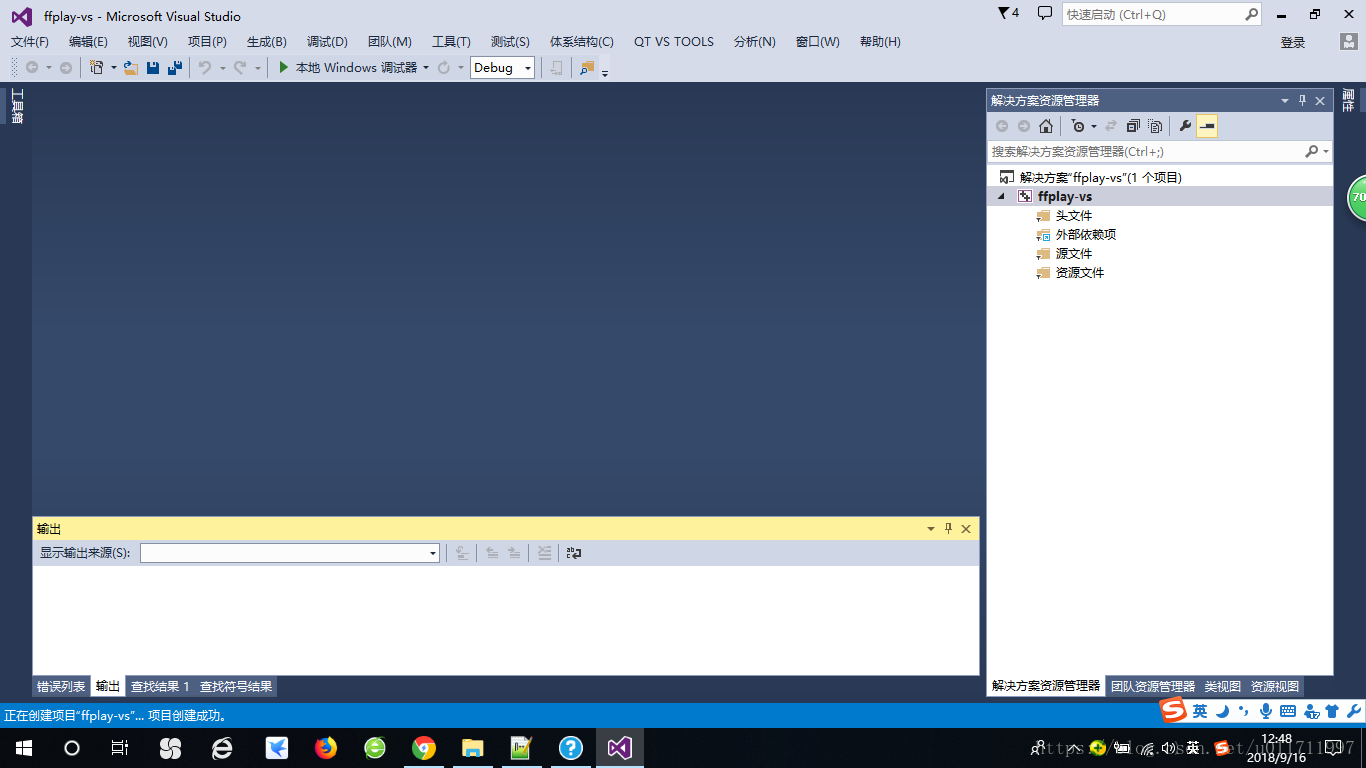

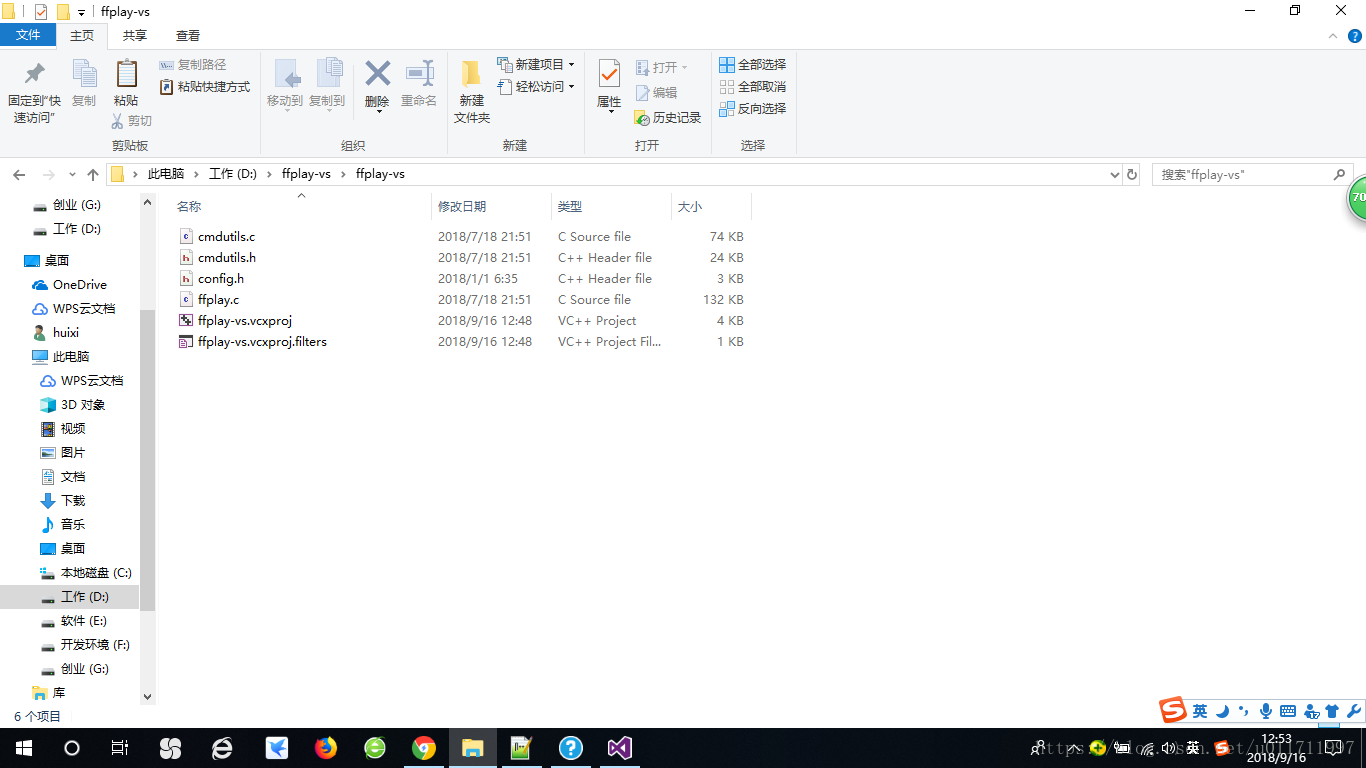

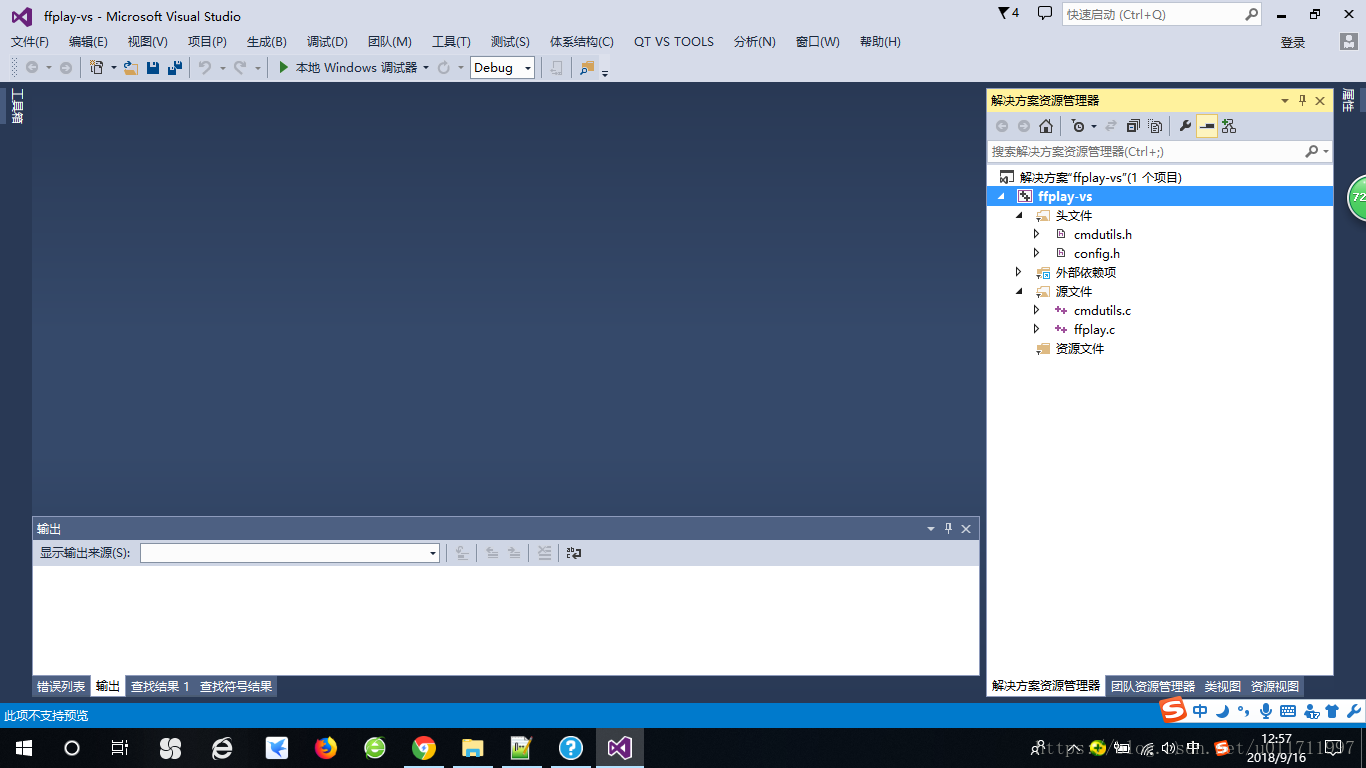

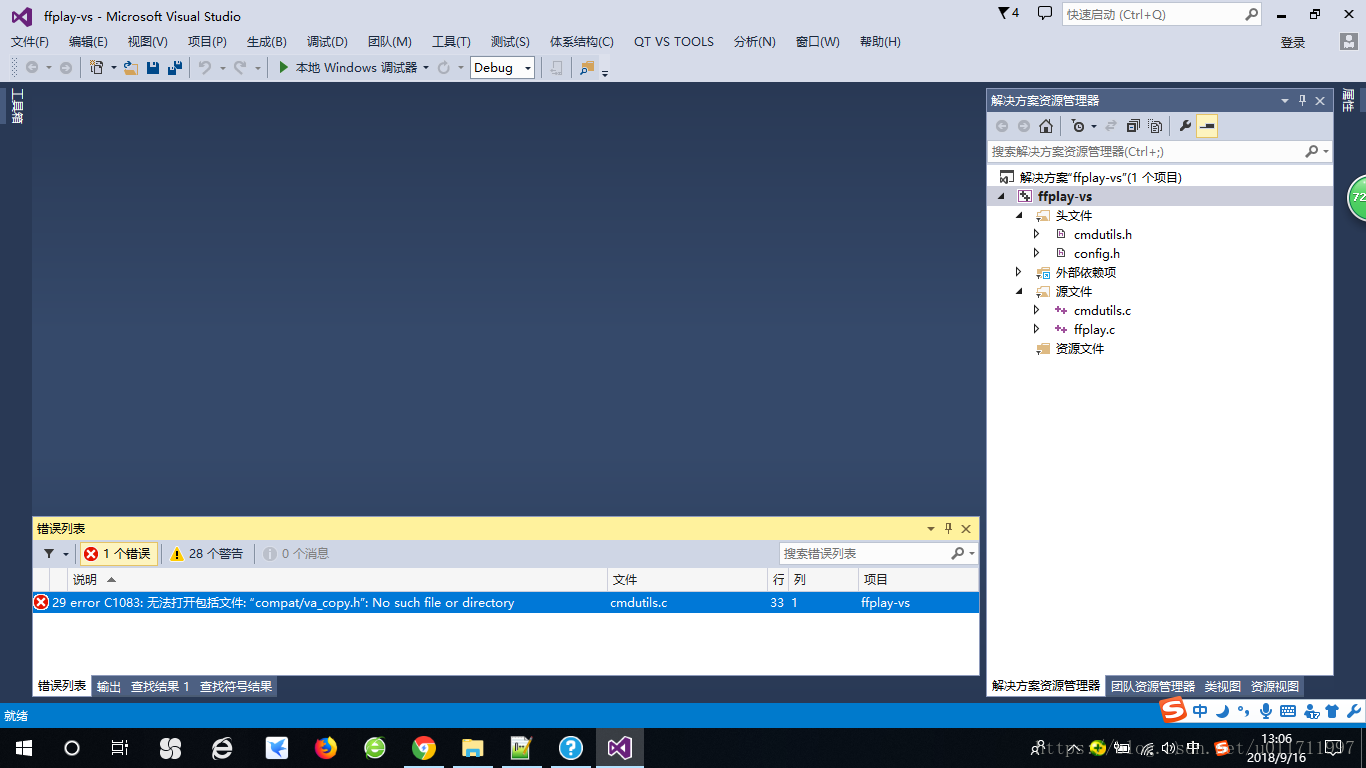

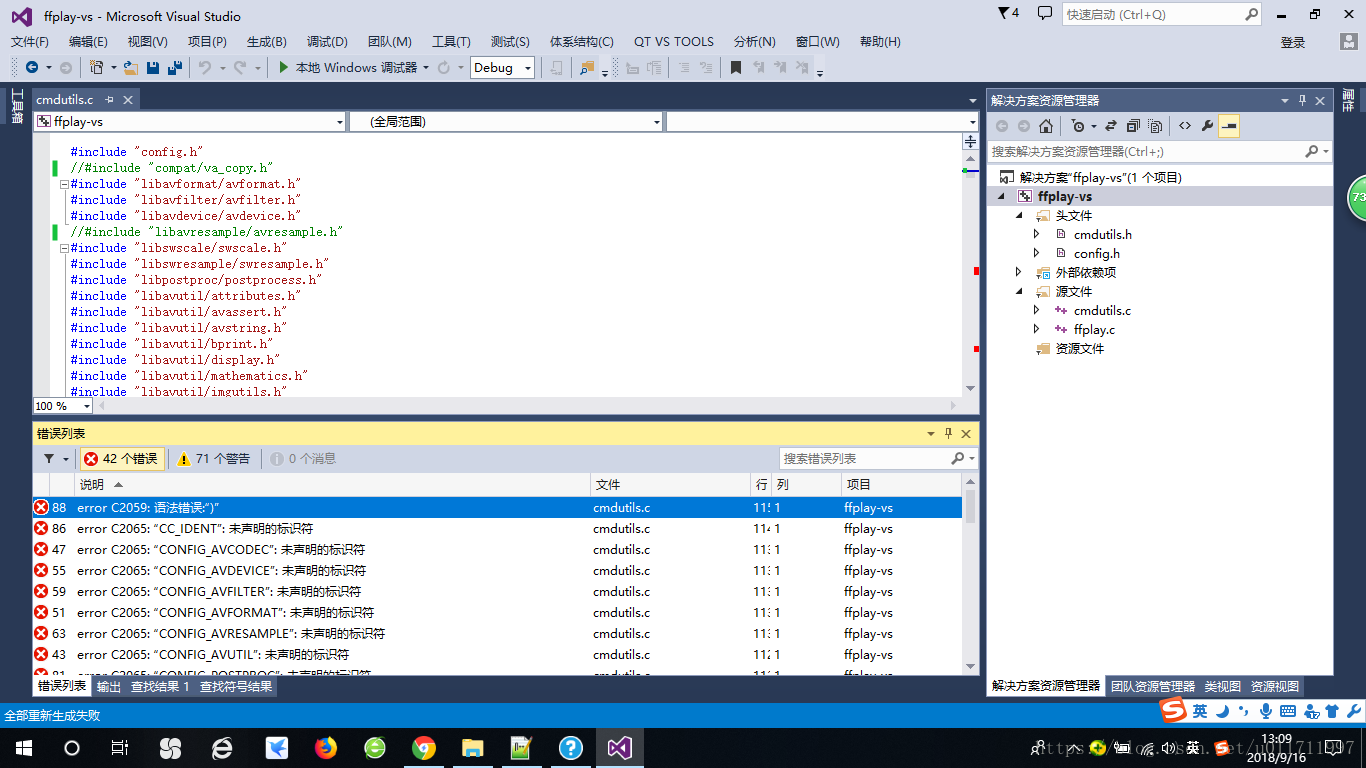

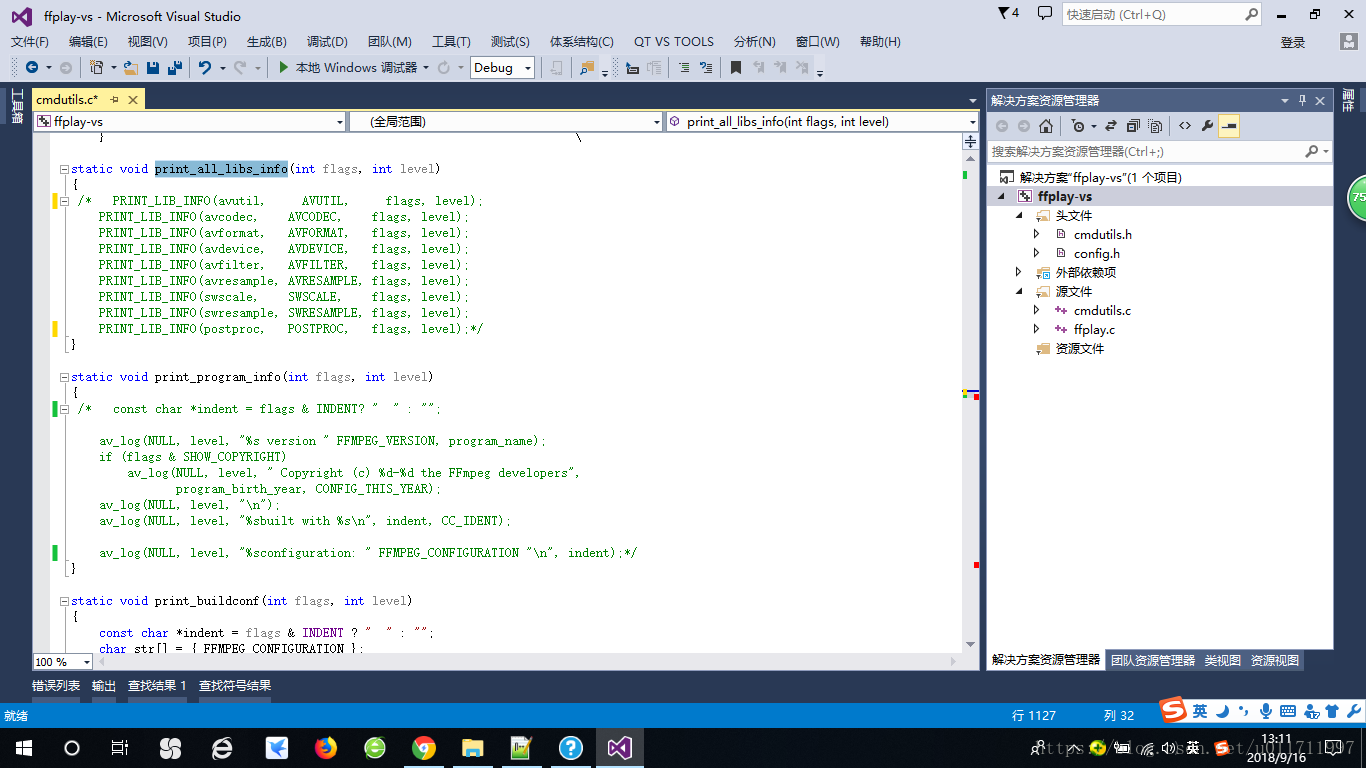

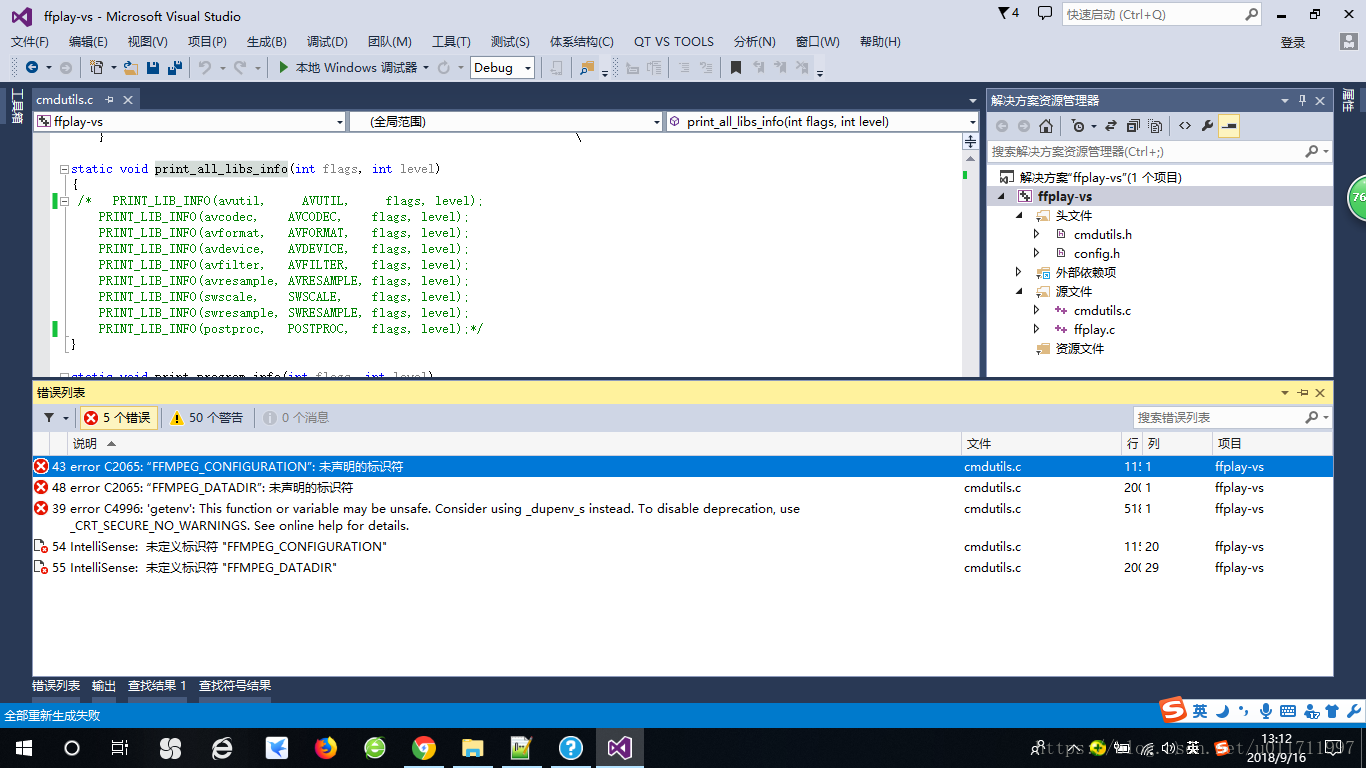

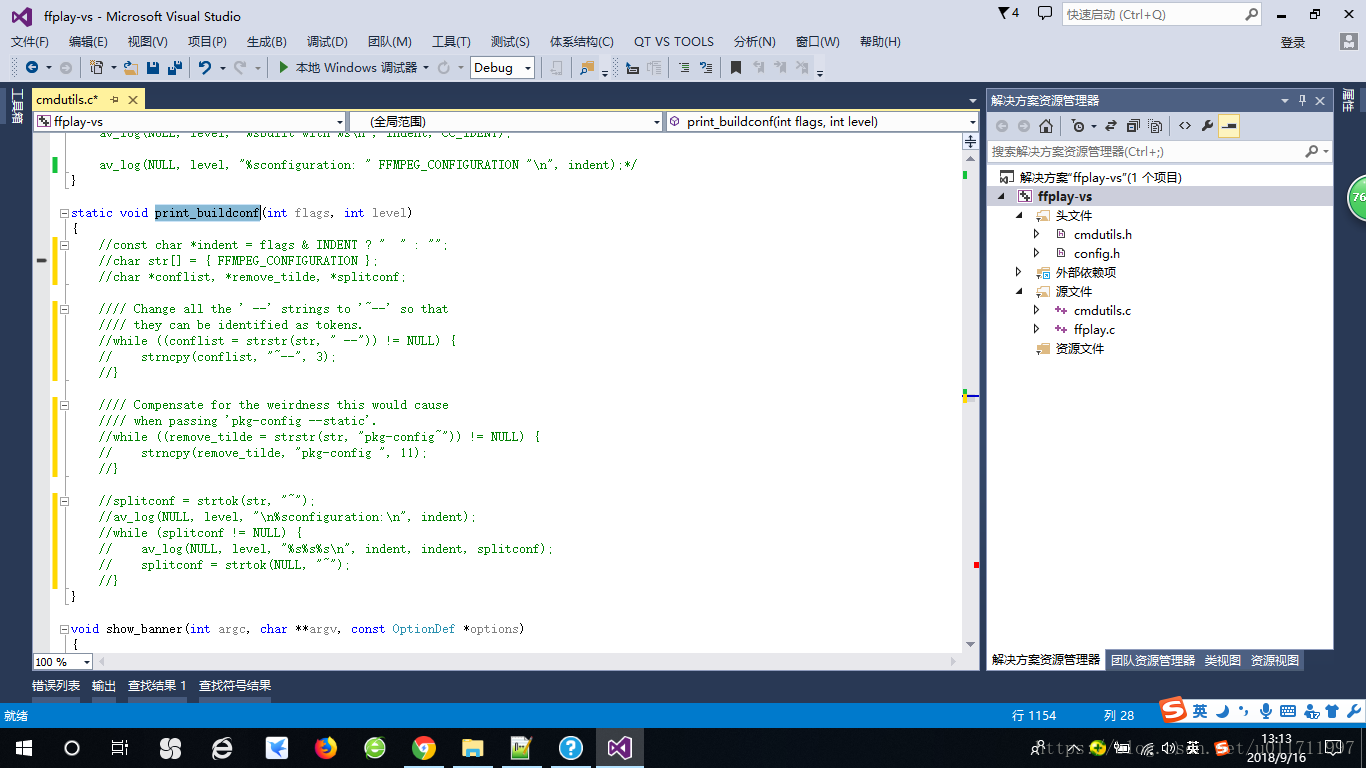

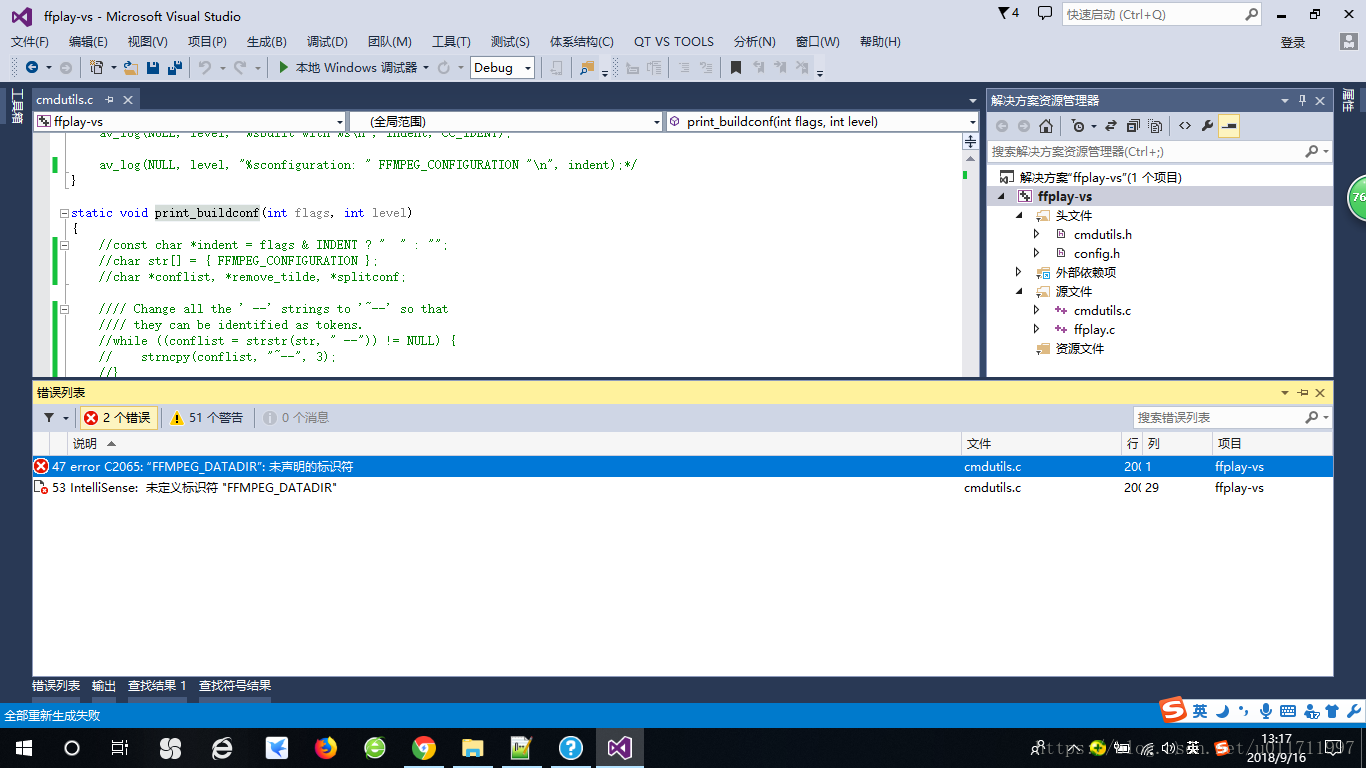

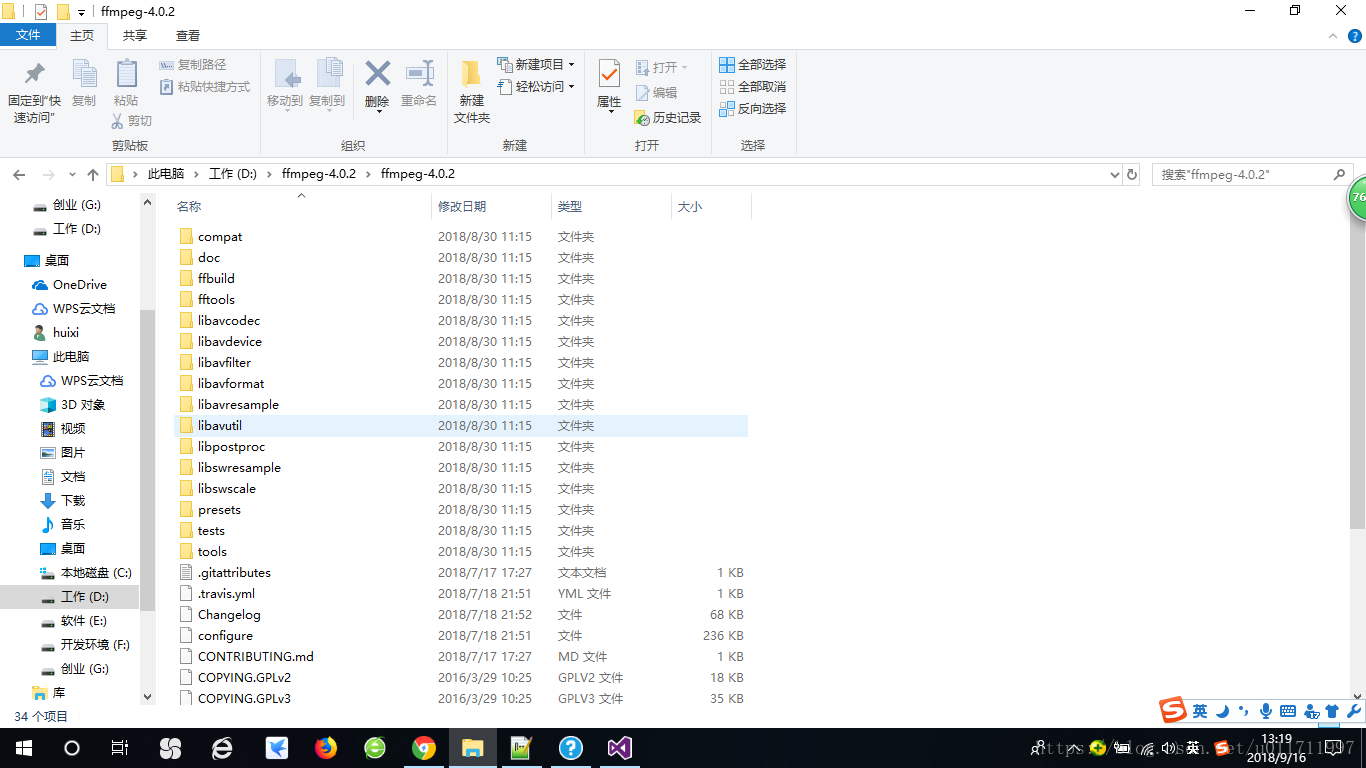

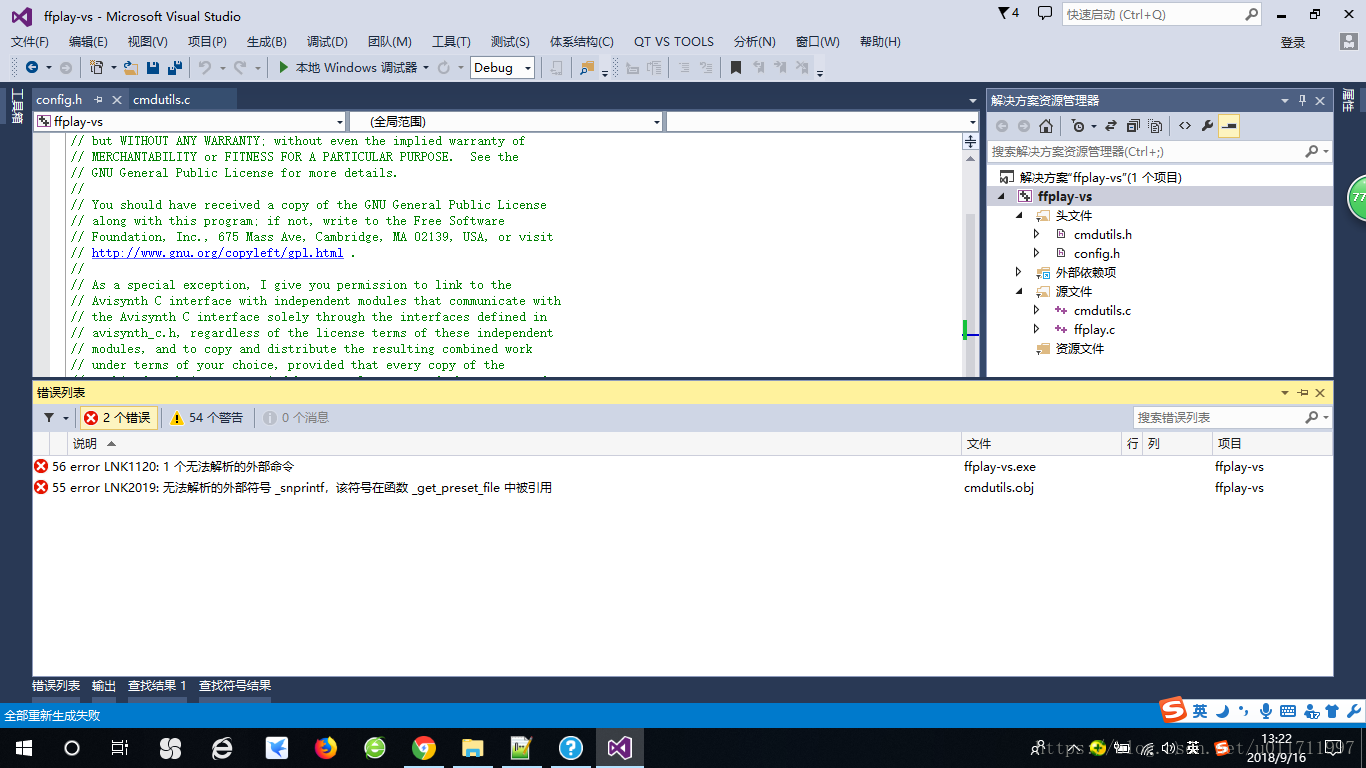

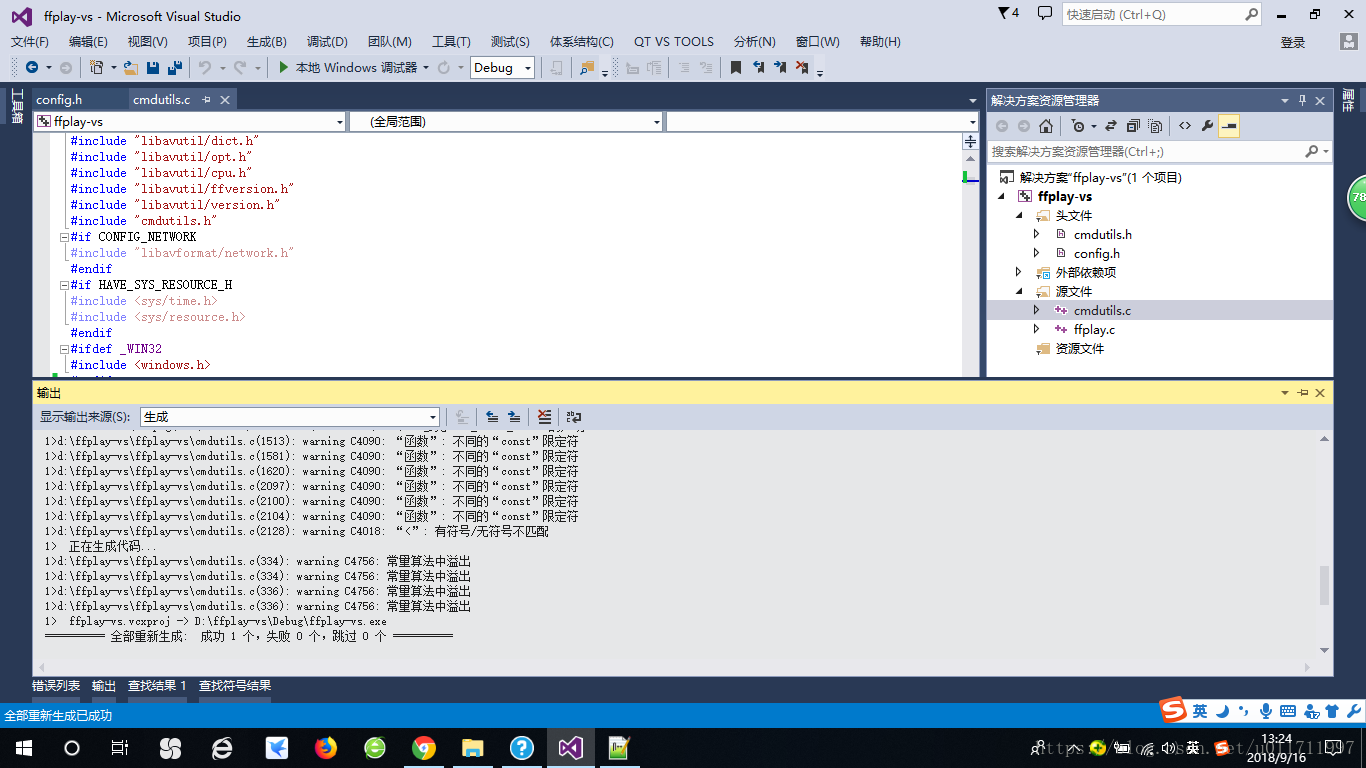

ffmpeg-4.0.2版本中ffplay播放器在vs2013下的编译

ffmpeg学习十一:滤镜(实现视频缩放,裁剪,水印等)

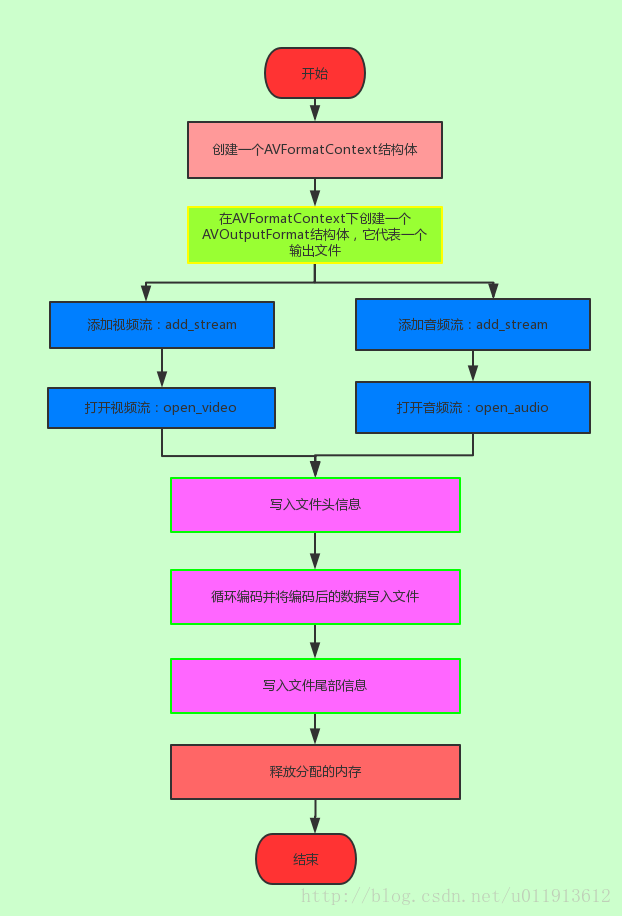

ffmpeg学习十:封装音视频到同一个文件(muxing.c源码分析)

ffmpeg学习七:软件生成yuv420p视频并将其编码为H264格式

ffmpeg学习六:avformat_find_stream_info函数解析

ffmpeg学习四:avformat_open_input函数源码分析

ffplay使用收集

This starts FFplay without the console window:

ProcessStartInfo startInfo = new ProcessStartInfo();

startInfo.UseShellExecute = false;

startInfo.CreateNoWindow = true;

startInfo.FileName = "ffplay";

startInfo.Arguments = "-f lavfi testsrc2=s=vga";

Process p = Process.Start(startInfo);

一、ffplay常用命令

播放完自动退出

ffplay -autoexit

播放桌面

ffplay -f gdigrab -i desktop

播放直播

ffplay -i https://epg.pw/stream/12222da81a59a4b766eebab3c8c43f4fa910637ea182be42e2affdae3ebb845c.m3u8

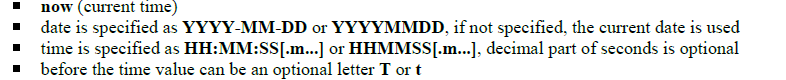

列举设备

ffmpeg -list_devices true -f dshow -i dummy

播放摄像头,麦克风声音

ffplay -f dshow -i video="USB2.0 Camera"

ffplay -f dshow -i audio="麦克风 (Realtek High Definition Audio)"

播放用ffmpeg加密的mp4文件,{mykey}为加密时所用的密钥

ffplay -decryption_key mykey -i encryption.mp4

播放本地m3u8视频

如果用加密,需要下载,.key文件,网络或ffmpeg加密时的密钥

在用notepad找开.m3u8文件,将URI=" ”改成密钥{.key}的本地路径,这样就解密了,可以像正常播放m3u8本地文件那样播放

播放本地m3u8视频

ffplay -allowed_extensions ALL -i playlist.m3u8

二、调整播放参数

常用命令格式

ffplay -allowed_extensions ALL -autoexit -alwaysontop -x 1280 -y 720 -window_title “cctv6 电影频道” -i https://epg.pw/stream/12222da81a59a4b766eebab3c8c43f4fa910637ea182be42e2affdae3ebb845c.m3u8

查看全部命令以下命令,保存后查看

ffplay -help > D:\ffplaycommand.txt

-allowed_extensions ALL 允许所有文件格式的输入,播放本地m3u8文件要用到。

-autoexit 播放完自动退出,对于直播流无效

-alwaysontop 窗口总显示在最前面

-x 1280 -y 720 调整窗口大小为1280*720

-window_title 设置窗口标题(默认为输入文件名)。

-showmode 1 -vn 显示音频流,禁用视频流,节省宽带与电脑性能,适用于国外纯音乐频道听歌

-vf scale=iw/2:ih/2 -vf视频滤镜,scale=iw/2:ih/2是播放时质量变成原来的一半

-vf histeq=0.200:0.210:weak 颜色分布调整

-vf hflip 水平翻转

-fs 全屏

-aspect 4:3 纵横比设置纵横比(4:3、16:9或1.3333、1.7777)

-an/vn/sn 禁用音、视频、字幕

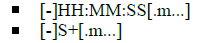

-ss 01:40:20 -t 60 没有 -to 这个用法,区别于ffmpeg

-bytes 按字节搜索。

-seek_interval 100 快进一次100秒

-nodisp禁用图形显示。

-noborder无边框窗口。

-volume [0-100]

-f fmt强制格式。

-left 0 设置窗口左侧的 x 位置(默认为居中窗口)。

-top 0 设置窗口顶部的 y 位置(默认为居中窗口)。

-loop 2 循环播放动画<2>次。0 表示永远。

-showmode 0/video 显示视频

-showmode 1/waves 显示音频波形

-showmode 2/rdft 使用 RDFT((逆)实离散傅里叶变换)显示音频频段

默认值为“视频”,如果视频不存在或无法播放 “RDFT”被自动选中。

您可以通过以下方式以交互方式循环切换可用的显示模式 按 W 键。

-af -filter:a 缩写 ,提示输入音频过滤器名称

三、窗口操作

鼠标拖动可以调节窗口到任意大小

鼠标左键双击 切换全屏

按q,ESC退出

暂停p,SPC

切换静音m

分别减少和增加音量。9, 0/, *

←/→ 向后/向前搜索 10 秒。

↓/↑ 向后/向前寻求 1 分钟。

PgUp/PgDn 寻求上一章/下一章。 或者如果没有章节 向后/向前搜索 10 分钟。

鼠标右键单击 播放进度跳到。

在当前程序中循环音频通道。v

循环视频频道。t

循环当前节目中的字幕频道。c

循环程序。w

循环视频过滤器或显示模式。s

四、批处理播放前设置参数

set SDL_AUDIODRIVER=directsound

chcp 65001

ffplay -allowed_extensions ALL -autoexit -alwaysontop -x 1280 -y 720 -window_title “cctv6 电影频道” -i https://epg.pw/stream/12222da81a59a4b766eebab3c8c43f4fa910637ea182be42e2affdae3ebb845c.m3u8

set SDL_AUDIODRIVER=directsound 为调用声卡的内容,一些笔记本无法自己调用

chcp 65001 调用中文编码,出现乱码时调用或去除

最后一行为ffplay命令,名称要加双引号,防止名称中有空格造成错误。

重命名为“cctv6 电影频道”,后缀改成.bat,双击即可播放文件。

ffmpeg 4.4版本对MP4文件进行AES-CTR加密,和流式加密

一、对于普通的加密方式

加密方式:

# 使用AES-128-CBC算法对视频文件进行加密

ffmpeg -i input.mp4 -c:v copy -c:a copy -encryption_scheme cenc-aes-ctr -encryption_key 0123456789ABCDEF0123456789ABCDEF -encryption_kid 0123456789ABCDEF0123456789ABCDEF encrypted.mp4

对应的解密

# 使用相同的密钥和KID对加密的视频文件进行解密

ffmpeg -decryption_key 0123456789ABCDEF0123456789ABCDEF -i encrypted.mp4 -c:v copy -c:a copy decrypted.mp4

ffplay -decryption_key 0123456789ABCDEF0123456789ABCDEF -i encrypted.mp4

直接使用下面的命令就行

ffmpeg -i animal.mp4 -vcodec copy -acodec copy -encryption_scheme cenc-aes-ctr -encryption_key c7e16c4403654b85847037383f0c2db3 -encryption_kid a7e61c373e219033c21091fa607bf3b8 -encryption_iv 1234567890abcdef1234567890abcdef encrypted_IV3.mp4

简单解释一下各种参数的作用,

-vcodec copy -acodec copy 只是将 animal.mp4的音视频数据直接拷贝到encrypted_IV3.mp4中

-encryption_scheme cenc-aes-ctr 表示采用的加密算法是cenc-aes-ctr

-encryption_key c7e16c4403654b85847037383f0c2db3 表是encryption_key 的值是c7e16c4403654b85847037383f0c2db3,这个值就是解密用的key

-encryption_kid a7e61c373e219033c21091fa607bf3b8 表示encryption_kid 的值是a7e61c373e219033c21091fa607bf3b8,加解密就是key和id的比对

-encryption_iv 1234567890abcdef1234567890abcdef 表示加密的初始向量IV为1234567890abcdef1234567890abcdef,这个参数可以不加,ffmpeg是有默认值的

encrypted_IV3.mp4 是加密后的MP4

播放的话,采用的是ffplay,命令行如下

ffplay encrypted_IV.mp4 -decryption_key c7e16c4403654b85847037383f0c2db3 -decryption_iv 1234567890abcdef1234567890abcdef

-decryption_key 解密用的密钥,就是加密的encryption_key的值

-decryption_iv 如果加密的时候有设置加密初始向量的值,那么这里也需要加,对应的是encryption_iv的值,如果加密的时候采用的是默认的,这里可以不加

对于代码加密代码,此处复制的别人的,项目并不需要这个,我就没做验证

AVDictionary *opts = NULL;

// 指定加密参数

av_dict_set(&format_opts, "encryption_scheme", "cenc-aes-ctr", 0);

av_dict_set(&format_opts, "encryption_key", "c7e16c4403654b85847037383f0c2db3", 0);

av_dict_set(&format_opts, "encryption_kid", "a7e61c373e219033c21091fa607bf3b8", 0);

ret = avformat_write_header(AVFormatContext, &format_opts);

解密的代码也是别人的,但我是经过验证的,确认可行

AVDictionary *format_opts = NULL;

// 指定解密key

av_dict_set(&format_opts, "decryption_key", "c7e16c4403654b85847037383f0c2db3", 0);

av_dict_set(&format_opts, "decryption_iv", "1234567890abcdef1234567890abcdef", 0);

err = avformat_open_input(&AVFormatContext, "path", AVInputFormat, &format_opts);

二、对于流式的加密方式

命令行如下

ffmpeg -i animal.mp4 -movflags frag_keyframe -encryption_scheme cenc-aes-ctr -encryption_key c7e16c4403654b85847037383f0c2db3 -encryption_kid a7e61c373e219033c21091fa607bf3b8 encrypted.mp4

重复的参数我就不赘述了,

-movflags 选项用于设置MOV或MP4容器(文件格式)的特定标志。这些标志会改变输出文件的结构或行为。

frag_keyframe 强制每个关键帧都开始一个新的片段,使文件适合于流式传输。这个参数就是区分流式还是普通的一个关键参数

播放的话和普通的一致。

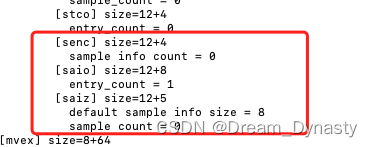

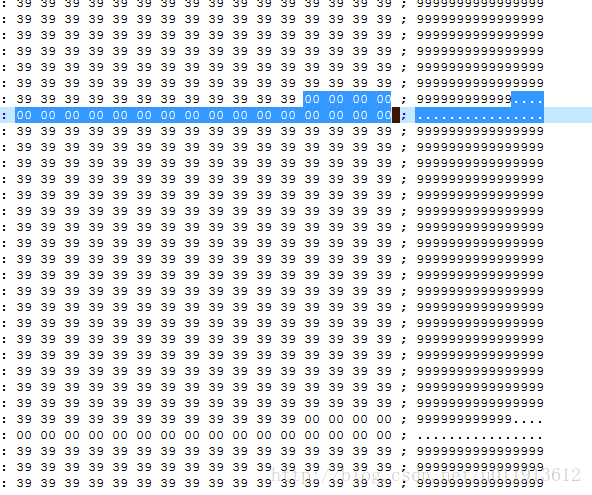

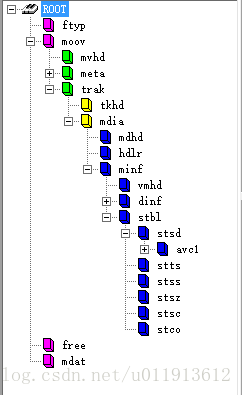

出现下面这三个字段,就是说明成功了。工具我用的是Bento4,Bento4有个命令mp4dump可以查看。

三、需要注意的是---moov

ffmpeg有一个参数,叫empty_moov 。当你创建一个MP4文件时,通常它首先写入一个moov原子(也就是元数据),然后是mdat原子(包含实际的音频/视频数据)。但是,如果你想开始记录并在之后添加元数据,你需要首先写入一个空的moov原子,简单理解就是:

普通的MP4 的格式(从上到下): moov -> data

加了empty_moov的MP4格式: empty_moov -> data -> moov

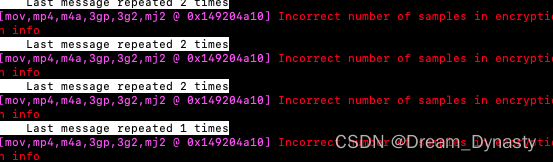

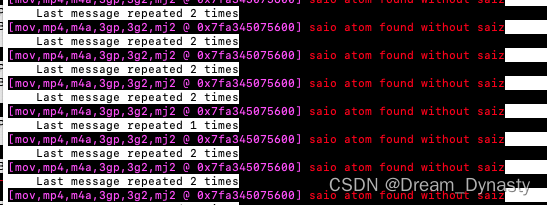

如果你把moov移动到了MP4末尾的同时做了aes-ctr加密,就会出错,因为ffmpeg在解密aes-ctr时要先知道加密的重要参数,而这个参数就在moov中,然后才能进行解密,如果moov放在了末尾,那ffmpeg就不知道要怎么解密了。该情况下我遇到的错误有下面几种

[mov,mp4,m4a,3gp,3g2,mj2 @ 0x149204a10] Incorrect number of samples in encryption info

[mov,mp4,m4a,3gp,3g2,mj2 @ 0x1426658b0] saio atom found without saiz

[h264 @ 0x7f93ba8a3e00] Invalid NAL unit size (217505651 > 1332).

[h264 @ 0x7f93ba8a3e00] Error splitting the input into NAL units.

ffmpeg加密推流

ffmpeg 推流到抖音

ffmpeg -re -i input.mp4 -c:v libx264 -preset veryfast -maxrate 1500k -bufsize 1500k -pix_fmt yuv420p -g 30 -c:a aac -b:a 128k -ar 44100 -ac 2 -f flv rtmp://your_douyin_rtmp_server/stream

请将input.mp4替换为你想要推流的视频文件路径,并将rtmp://your_douyin_rtmp_server/stream替换为你从抖音获取的实际RTMP服务器地址。

确保你的FFmpeg版本是最新的,以支持与抖音服务器的RTMP流媒体传输。如果你需要更多的推流参数定制,请查看FFmpeg的官方文档以获取更多信息。

其他命令:

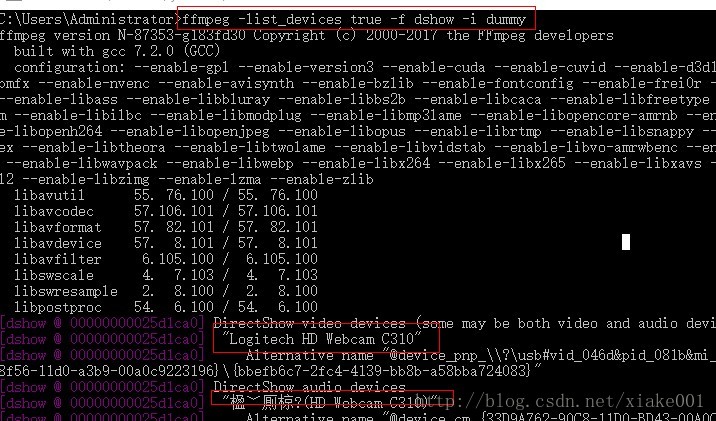

ffmpeg查看电脑设备

输入下面的语句即可列出电脑的设备

ffmpeg -list_devices true -f dshow -i dummy

测试摄像头是否可用

cmd中输入下面语句并回车(USB2.0 PC CAMERA为摄像头名称)

ffplay -f dshow -i video="USB2.0 PC CAMERA"

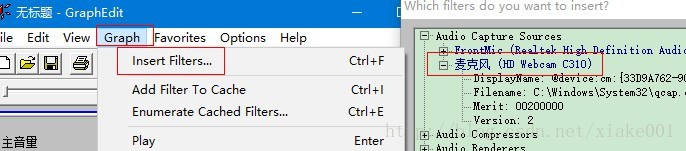

查看摄像头和麦克风信息

cmd中输入下面语句即可查询摄像头信息

ffmpeg -list_options true -f dshow -i video="USB2.0 PC CAMERA"

cmd中输入下面语句即可查询麦克风信息

ffmpeg -list_options true -f dshow -i audio="麦克风 (2- USB2.0 MIC)"

本地视频的推流

ffmpeg.exe -re -i demo.wmv -f flv rtmp://127.0.0.1:1935/live/123

摄像头推流

ffmpeg -f dshow -i video="USB2.0 PC CAMERA" -vcodec libx264 -preset:v ultrafast -tune:v zerolatency -f flv rtmp://127.0.0.1:1935/live/123

麦克风推流

ffmpeg -f dshow -i audio="麦克风 (2- USB2.0 MIC)" -vcodec libx264 -preset:v ultrafast -tune:v zerolatency -f flv rtmp://127.0.0.1:1935/live/123

摄像头&麦克风推流

ffmpeg -f dshow -i video="USB2.0 PC CAMERA" -f dshow -i audio="麦克风 (2- USB2.0 MIC)" -vcodec libx264 -preset:v ultrafast -tune:v zerolatency -f flv rtmp://127.0.0.1:1935/live/123

或者

ffmpeg -f dshow -i video="USB2.0 PC CAMERA":audio="麦克风 (2- USB2.0 MIC)" -vcodec libx264 -r 25 -preset:v ultrafast -tune:v zerolatency -f flv rtmp://127.0.0.1:1935/live/123

ffmpeg 命令行编程相关

ffmpeg命令行帮助

ffmpeg -h

ffmpeg -h long

ffmpeg -h full

ffmpeg -h type=name

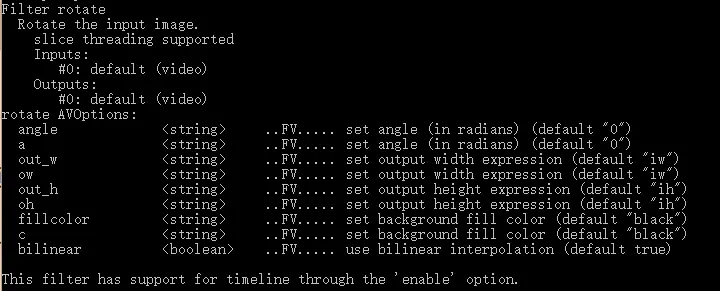

ffmpeg -h filter=scale

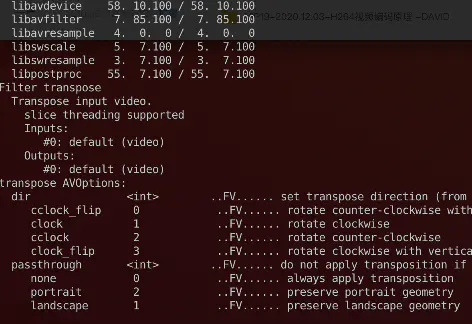

输出如下:

scale AVOptions:

w <string> ..FV..... Output video width

width <string> ..FV..... Output video width

h <string> ..FV..... Output video height

height <string> ..FV..... Output video height

flags <string> ..FV..... Flags to pass to libswscale (default "bilinear")

interl <boolean> ..FV..... set interlacing (default false)

in_color_matrix <string> ..FV..... set input YCbCr type (default "auto")

out_color_matrix <string> ..FV..... set output YCbCr type

in_range <int> ..FV..... set input color range (from 0 to 2) (default auto)

...

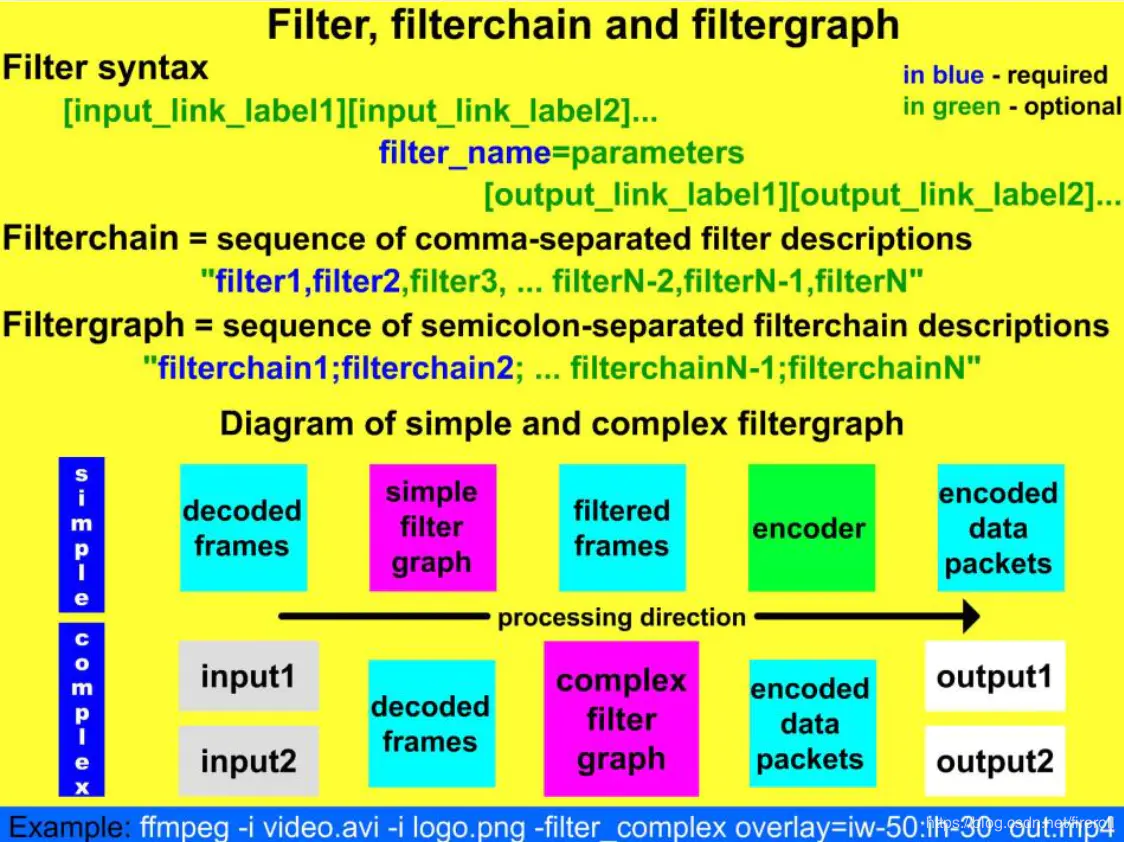

这就告诉我们scale滤镜有w、h等参数,我们就这样使用scale滤镜,

ffmpeg -i input.mp4 -filter_complex "scale=w=iw/2h=ih/2" output.mp4

其中iw代表输入视频的宽,ih代表输入视频的高,这条命令就把输入的视频缩小一倍,这里你可能会有疑问,我都不记得那些滤镜的名字,就无法使用这个去查了,哈哈不要急,还记得上面的帮助命令吗,ffmpeg -filters可以输出所有的滤镜名字了,如果你觉的输出太多,你不好找的话,你只要记得这个滤镜大概是叫什么名字、包含什么字母,你就借助grep指令去输出里面搜索关键字,这样就只会输出你关心的滤镜名了,如ffmpeg -filters | grep over

-h topic show help

-? topic show help

-help topic show help

--help topic show help

-version show version

-buildconf show build configuration

-formats show available formats

-muxers show available muxers

-demuxers show available demuxers

-devices show available devices

-codecs show available codecs

-decoders show available decoders

-encoders show available encoders

-bsfs show available bit stream filters

-protocols show available protocols

-filters show available filters

-pix_fmts show available pixel formats

-layouts show standard channel layouts

-sample_fmts show available audio sample formats

-dispositions show available stream dispositions

-colors show available color names

-sources device list sources of the input device

-sinks device list sinks of the output device

-hwaccels show available HW acceleration methods

Global options (affect whole program instead of just one file):

-loglevel loglevel set logging level

-v loglevel set logging level

-report generate a report

-max_alloc bytes set maximum size of a single allocated block

-y overwrite output files

-n never overwrite output files

-ignore_unknown Ignore unknown stream types

-filter_threads number of non-complex filter threads

-filter_complex_threads number of threads for -filter_complex

-stats print progress report during encoding

-max_error_rate maximum error rate ratio of decoding errors (0.0: no errors, 1.

0: 100% errors) above which ffmpeg returns an error instead of success.

Per-file main options:

-f fmt force format

-c codec codec name

-codec codec codec name

-pre preset preset name

-map_metadata outfile[,metadata]:infile[,metadata] set metadata information of

outfile from infile

-t duration record or transcode "duration" seconds of audio/video

-to time_stop record or transcode stop time

-fs limit_size set the limit file size in bytes

-ss time_off set the start time offset

-sseof time_off set the start time offset relative to EOF

-seek_timestamp enable/disable seeking by timestamp with -ss

-timestamp time set the recording timestamp ('now' to set the current time)

-metadata string=string add metadata

-program title=string:st=number... add program with specified streams

-target type specify target file type ("vcd", "svcd", "dvd", "dv" or "dv5

0" with optional prefixes "pal-", "ntsc-" or "film-")

-apad audio pad

-frames number set the number of frames to output

-filter filter_graph set stream filtergraph

-filter_script filename read stream filtergraph description from a file

-reinit_filter reinit filtergraph on input parameter changes

-discard discard

-disposition disposition

Video options:

-vframes number set the number of video frames to output

-r rate set frame rate (Hz value, fraction or abbreviation)

-fpsmax rate set max frame rate (Hz value, fraction or abbreviation)

-s size set frame size (WxH or abbreviation)

-aspect aspect set aspect ratio (4:3, 16:9 or 1.3333, 1.7777)

-display_rotation angle set pure counter-clockwise rotation in degrees for stre

am(s)

-display_hflip set display horizontal flip for stream(s) (overrides any dis

play rotation if it is not set)

-display_vflip set display vertical flip for stream(s) (overrides any displ

ay rotation if it is not set)

-vn disable video

-vcodec codec force video codec ('copy' to copy stream)

-timecode hh:mm:ss[:;.]ff set initial TimeCode value.

-pass n select the pass number (1 to 3)

-vf filter_graph set video filters

-b bitrate video bitrate (please use -b:v)

-dn disable data

Audio options:

-aframes number set the number of audio frames to output

-aq quality set audio quality (codec-specific)

-ar rate set audio sampling rate (in Hz)

-ac channels set number of audio channels

-an disable audio

-acodec codec force audio codec ('copy' to copy stream)

-ab bitrate audio bitrate (please use -b:a)

-af filter_graph set audio filters

Subtitle options:

-s size set frame size (WxH or abbreviation)

-sn disable subtitle

-scodec codec force subtitle codec ('copy' to copy stream)

-stag fourcc/tag force subtitle tag/fourcc

-fix_sub_duration fix subtitles duration

-canvas_size size set canvas size (WxH or abbreviation)

-spre preset set the subtitle options to the indicated preset

得到ffmpeg命令行输出

SynchronizationContext SyncContext = null;

public Form1()

{

InitializeComponent();

SyncContext = SynchronizationContext.Current;

}

void soundProcess(string infn, string outfn)

{

string aa, aa2;

aa = aa2 = "DEAD";

var app = new Process();

string param = "",outString="";

app.StartInfo.UseShellExecute = false;

app.StartInfo.RedirectStandardOutput = true;

app.StartInfo.RedirectStandardError = true;

app.StartInfo.CreateNoWindow = true;

app.StartInfo.WindowStyle = ProcessWindowStyle.Hidden;

app.StartInfo.FileName = @"ffmpeg.exe";

//app.StartInfo.Arguments = string.Format(@"-i ""{0}"" -ab 192k -y {2} ""{1}""", infn, outfn, param);

app.StartInfo.Arguments = string.Format(@"-i ""{0}"" -f mp3 -acodec libmp3lame -y ""{1}""", infn, outfn);

app.EnableRaisingEvents = true;

List<string> m_outList = new List<string>();

app.Start();

try

{

app.PriorityClass = ProcessPriorityClass.BelowNormal;

}

catch (Exception ex)

{

if (!Regex.IsMatch(ex.Message, @"Cannot process request because the process .*has exited"))

throw ex;

}

app.Exited += (s, a) =>

{

SyncContext.Post(m =>

{

MessageBox.Show("退出");

}, "");

return;

};

app.OutputDataReceived += (s, a) =>

{

if (a.Data == null)

{

//mre_output.Set();

return;

}

};

app.ErrorDataReceived += (s, a) =>

{

if (a.Data == null)

{

//mre_error.Set();

//MessageBox.Show(outString);

SyncContext.Post(m => {

var result = m as List<string>;

textBox1.Lines = result.ToArray();

}, m_outList);

return;

}

else

{

outString += a.Data;

m_outList.Add(a.Data);

}

};

}

soundProcess("c:\\outmp3\\1_cd.wav", "c:\\out\\cd.mp3");

得到ffmpeg命令行内存输出

void soundProcessMem(string infn, string outfn)

{

string aa, aa2;

aa = aa2 = "DEAD";

var app = new Process();

string param = "", outString = "";

app.StartInfo.UseShellExecute = false;

app.StartInfo.RedirectStandardOutput = true;

app.StartInfo.RedirectStandardError = true;

app.StartInfo.CreateNoWindow = true;

app.StartInfo.WindowStyle = ProcessWindowStyle.Hidden;

//*/

app.StartInfo.FileName = @"ffmpeg.exe";

//app.StartInfo.Arguments = string.Format(@"-i ""{0}"" -ab 192k -y {2} ""{1}""", infn, outfn, param);

app.StartInfo.Arguments = string.Format(@"-i ""{0}"" -f mp3 -acodec libmp3lame -y pipe:1", infn);

app.EnableRaisingEvents = true;

List<string> m_outList = new List<string>();

app.Start();

try

{

app.PriorityClass = ProcessPriorityClass.BelowNormal;

}

catch (Exception ex)

{

if (!Regex.IsMatch(ex.Message, @"Cannot process request because the process .*has exited"))

throw ex;

}

FileStream baseStream = app.StandardOutput.BaseStream as FileStream;

app.Exited += (s, a) =>

{

SyncContext.Post(m =>

{

MessageBox.Show("退出");

}, "");

return;

};

app.OutputDataReceived += (s, a) =>

{

if (a.Data == null)

{

//mre_output.Set();

return;

}

};

app.ErrorDataReceived += (s, a) =>

{

if (a.Data == null)

{

//mre_error.Set();

//MessageBox.Show(outString);

SyncContext.Post(m =>

{

var result = m as List<string>;

textBox1.Lines = result.ToArray();

}, m_outList);

return;

}

else

{

outString += a.Data;

m_outList.Add(a.Data);

}

};

byte[] audioData;

int lastRead = 0;

using (MemoryStream ms = new MemoryStream())

{

byte[] buffer = new byte[5000];

do

{

lastRead = baseStream.Read(buffer, 0, buffer.Length);

ms.Write(buffer, 0, lastRead);

} while (lastRead > 0);

audioData = ms.ToArray();

}

using (FileStream s = new FileStream(outfn, FileMode.Create))

{

s.Write(audioData, 0, audioData.Length);

}

//aa = app.StandardOutput.ReadToEnd();

// app.BeginOutputReadLine();

//app.BeginErrorReadLine();

}

private void button5_Click(object sender, EventArgs e)

{

soundProcessMem("c:\\outmp3\\1_cd.wav", "c:\\out\\cd.mp3");

return;

}

内存数据

var proc= new Process();

。。。

FileStream baseStream = proc.StandardOutput.BaseStream as FileStream;

byte[] audioData;

int lastRead = 0;

using (MemoryStream ms = new MemoryStream())

{

byte[] buffer = new byte[5000];

do

{

lastRead = baseStream.Read(buffer, 0, buffer.Length);

ms.Write(buffer, 0, lastRead);

} while (lastRead > 0);

audioData = ms.ToArray();

}

using(FileStream s = new FileStream(Path.Combine(WorkingFolder, "pipe_output_01.mp3"), FileMode.Create))

{

s.Write(audioData, 0, audioData.Length);

}

将视频文件转为m3u8

ffmpeg -i D:\video\video.mp4 -c:v libx264 -hls_time 10 -hls_list_size 0 -c:a aac -strict -2 -f hls D:\video\9s.m3u8

一次性完成转换和切片,切片时长为10秒,这样就会切出每个10秒的视频片段。

通过ffmpeg转码后的,如何给某几个ts单独添加水印

视频添加水印和压缩:

ffmpeg -i g:\hy.mp4 -i g:\logo.png -filter_complex overlay -c:v libx264 -c:a aac -strict -2 -f hls -hls_list_size 0 -hls_time 15 g:\videos\hy.m3u8

默认的每片长度为 2 秒,m3u8 文件中默认只保存最新的 5 条片的信息,导致最后播放的时候只能播最后的一小部分(直播的时候特别注意)。

-hls_time n 设置每片的长度,默认值为 2,单位为秒。

-hls_list_size n 设置播放列表保存的最多条目,设置为 0 会保存有所片信息,默认值为5。

-hls_wrap n 设置多少片之后开始覆盖,如果设置为0则不会覆盖,默认值为0。这个选项能够避免在磁盘上存储过多的 片,而且能够限制写入磁盘的最多的片的数量。

-hls_start_number n 设置播放列表中 sequence number 的值为 number,默认值为 0。

注意:播放列表的 sequence number 对每个 segment 来说都必须是唯一的,而且它不能和片的文件名(当使用 wrap 选项时,文件名有可能会重复使用)混淆。

ffmpeg -i g:\hy.mp4 -vf "drawtext='fontfile=FreeSans.ttf:text=anlun_xn:fontcolor=red'" -c:v libx264 -c:a aac -strict -2 -f hls -hls_list_size 0 -hls_time 15 g:\videos\hy.m3u8

ffmpeg -i g:\hy.mp4 -vf "drawtext='fontfile=FreeSans.ttf:text=anlun_xn:fontcolor=red:x=if(eq(mod(t,30),0),rand(0,(W-tw)),x): y=if(eq(mod(t,30),0),rand(0,(H-th)),y)'" -c:v libx264 -c:a aac -strict -2 -f hls -hls_list_size 0 -hls_time 15 g:\videos\hy.m3u8

m3u8内容介绍

EXTM3U:这个是M3U8文件必须包含的标签,并且必须在文件的第一行,所有的M3U8文件中必须包含这个标签。

EXT-X-VERSION:M3U8文件的版本,常见的是3(目前最高版本应该是7)。

EXT-X-TARGETDURATION:该标签指定了媒体文件持续时间的最大值,播放文件列表中的媒体文件在EXTINF标签中定义的持续时间必须小于或者等于该标签指定的持续时间。该标签在播放列表文件中必须出现一次。

EXT-X-MEDIA-SEQUENCE:M3U8直播是的直播切换序列,当播放打开M3U8时,以这个标签的值作为参考,播放对应的序列号的切片。

EXTINF:EXTINF为M3U8列表中每一个分片的duration,如上面例子输出信息中的第一片的duration为10秒。在EXTINF标签中,除了duration值,还可以包含可选的描述信息,主要为标注切片信息,使用逗号分隔开。

MIME里加入

.m3u8 application/octet-stream

.ts application/octet-stream

MIME配置问题

(1) 在VS启动中必须配置下文件播放地址

<staticContent>

<mimeMap fileExtension=".m3u8" mimeType="application/x-mpegURL" />

<!--<mimeMap fileExtension=".ts" mimeType="video/MP2T" />-->

</staticContent>

(2)当发布的时候需要配置IIS的

.m3u8 application/x-mpegURL

.ts video/MP2T

这里有个坑,当我用上面命令行生成hls视频后,我发现每个ts的时长不是我指定的2s,而是10s。查阅资料后发现,ts切片的大小严格依赖于原始视频的GOP大小,因为必选保证一个ts内至少包含一个GOP,否则这个ts分片就无法使用。当然解决方式也很简单,我们只需要再新增一个参数 -force_key_frames "expr:gte(t,n_forced*2)" 这个参数的作用就是让视频GOP大小为2s,这样就能保证ts分片大小是我们想要的2s了。 完整命令如下:

ffmpeg -i input.mp4 -c:v copy -force_key_frames "expr:gte(t,n_forced*2)" -hls_time 2 -hls_segment_filename %d.ts -f hls output/playlist.m3u8

ffmpeg -i g:\hy.mp4 -vf "drawtext='fontfile=FreeSans.ttf:text=anlun_xn:fontcolor=red:x=if(eq(mod(t,30),0),rand(0,(W-tw)),x): y=if(eq(mod(t,30),0),rand(0,(H-th)),y)'" -c:v libx264 -c:a aac -strict -2 -f hls -hls_list_size 0 -hls_time 15 -force_key_frames "expr:gte(t,n_forced*15)" g:\videos\hy.m3u8

基于c#生成M3U8或者M3U格式的HLS视频流

生成M3U8或者M3U格式的HLS视频流可以通过以下步骤实现:

1. 将视频文件转换为HLS格式的视频流;

2. 生成M3U8或者M3U文件,指定视频流文件的地址和长度信息;

3. 将生成的M3U8或者M3U文件上传到服务器,供客户端访问。

以下是一个基于c#生成M3U8文件的示例代码:

using System;

using System.IO;

using System.Text;

namespace M3U8Generator

{

class Program

{

static void Main(string[] args)

{

string baseFilePath = @"D:\video\";

string m3u8FilePath = baseFilePath + "video.m3u8";

string tsFolder = baseFilePath + "ts\\";

string videoFileName = "video.mp4";

int segmentDuration = 10;

int segmentCount = 0;

StringBuilder sb = new StringBuilder();

sb.AppendLine("#EXTM3U");

sb.AppendLine("#EXT-X-VERSION:3");

sb.AppendLine("#EXT-X-TARGETDURATION:" + segmentDuration);

sb.AppendLine("#EXT-X-MEDIA-SEQUENCE:0");

// 分段处理视频流

while (true)

{

string tsFileName = "segment_" + segmentCount.ToString().PadLeft(5, '0') + ".ts";

string tsFilePath = tsFolder + tsFileName;

int length = Convert.ToInt32(segmentDuration * 1000);

if (File.Exists(tsFilePath))

{

string segmentLine = string.Format("#EXTINF:{0},\r\n{1}", length, tsFileName);

sb.AppendLine(segmentLine);

segmentCount++;

}

else

{

break;

}

}

File.WriteAllText(m3u8FilePath, sb.ToString());

Console.WriteLine("M3U8 file generated successfully.");

}

}

}

注解:

1. 代码中的baseFilePath、videoFileName、segmentDuration、tsFolder分别代表视频文件所在的路径、视频文件名、每个分段的时长(单位:秒)、保存分段视频流的文件夹。

2. 在分段处理视频流时,需要保证每个分段视频流的文件名是“segment_00000.ts”、“segment_00001.ts”等等,这样才能在生成M3U8文件时正确地指定每个分段的地址。

3. 代码中使用了StringBuilder来拼接M3U8文件的内容。在使用StringBuilder时,需要注意线程安全性和字符串的编码方式。

ffmpeg推流

rtmp推流 ffmpeg -re -stream_loop -1 -i f:/mp4/10.mp4 -c copy -f flv rtmp://192.168.0.110:6908/stream

rtsp推流 ffmpeg -re -stream_loop -1 -i f:/mp4/10.mp4 -c copy -f rtsp rtsp://192.168.0.110:6907/stream

远程推流 ffmpeg -re -stream_loop -1 -i f:/mp4/11.mp4 -c copy -f flv rtmp://47.114.127.78:6908/stream

网络设备 ffmpeg -i rtsp://admin:Admin123456@192.168.0.64:554/Streaming/Channels/101 -c copy -f flv rtmp://192.168.0.110:6908/stream

重新编码 ffmpeg -i "rtsp://admin:Admin123456@192.168.0.64:554/Streaming/Channels/101?transportmode=unicast&profile=Profile_2" -vcodec libx264 -acodec aac -f flv rtmp://192.168.0.110:6908/stream

实时桌面 ffmpeg -f gdigrab -r 30 -i desktop -vcodec libx264 -preset:v ultrafast -tune:v zerolatency -f rtsp -g 5 -an rtsp://192.168.0.110:6907/stream

本地设备 ffmpeg -f dshow -i video="USB Video Device":audio="麦克风 (USB Audio Device)" -vcodec libx264 -preset:v ultrafast -tune:v zerolatency -f rtsp rtsp://192.168.0.110:6907/stream

播放设备 ffplay -f dshow video="USB Video Device":audio="麦克风 (USB Audio Device)"

执行ffmpeg/ffplay 命令行不显示顶部固定编译参数等信息 -hide_banner,不要打印任何日志信息包括实时的解码编码信息 -loglevel quiet。

ffmpeg为视频设置透明度的几种方案

方案一:推荐在这里插入图片描述

ffmpeg -i a2.mp4 -i a3.mp4 -filter_complex [0:v]format=yuva444p,colorchannelmixer=aa=0.5[valpha];[1:v][valpha]overlay=(W-w)/2:(H-h)/2 -ss 0 -t 5 -y overlay4.mp4

方案二:对图片有效,经过测试

ffmpeg -i in4.png -i a3.mp4 -filter_complex [0:v]geq=a='122':lum='lum(X,Y)':cb='cb(X,Y)':cr='cr(X,Y)'[topV];[1:v][topV]overlay=(W-w)/2:(H-h)/2 -ss 0 -t 5 -y overlay3.mp4

同方案二,只是先将视频转换成一张张帧序列然后再使用方案二

此处经过测试,同样在ffmpeg 4.13下。Windows,Android,iOS 只有IOS下可以对视频进行geq,所以其他平台只能先转换成图片序列,然后再做geq

//此处经过测试,同样在ffmpeg 4.13下。Windows,Android,iOS 只有IOS下可以对视频进行geq

ffmpeg -i a2.mp4 -i a3.mp4 -filter_complex [0:v]geq=a='122':lum='lum(X,Y)':cb='cb(X,Y)':cr='cr(X,Y)'[topV];[1:v][topV]overlay=(W-w)/2:(H-h)/2 -ss 0 -t 5 -y overlay2.mp4

使用ffmpeg将PNG图片序列转为透明背景视频的命令行如下:

ffmpeg -i %d.png -vcodec qtrle movie_with_alpha.mov

ffmpeg -i %d.png -vcodec ffvhuff movie_with_alpha.avi

ffmpeg -i %d.png -vcodec huffyuv movie_with_alpha.avi

绿幕视频变透明背景

#(将没有透明通道的mp4格式转换为带透明通道的mov)

'ffmpeg -i input.mp4 -vf "chromakey=0x00FF00:0.2:0.3" -c copy -c:v png output.mov'

#(这一行的输出结果在web端播放是透明的,在本地播放是 绿幕)

'ffmpeg -y -i output.mov -vf "chromakey=0x00FF00:0.25:0.1" -c copy -c:v libvpx-vp9 -c:a libopus output.webm'

参数说明:

-vf: 指定应用于视频的视频过滤器。

chromakey: 指定要应用的视频过滤器名称,即绿幕抠图。

0x00FF00: 指定绿幕背景的颜色值,这里是绿色(RGB颜色值)。

0.2: 指定要抠图的颜色范围宽度,即相似度阈值。范围在0到1之间,数值越小则颜色抠图越精确。

0.3: 指定抠图时所使用的平滑因子,范围在0到1之间,数值越大则抠图结果越平滑。

按指定尺寸对视频进行裁剪

查看原视频尺寸

ffprobe -v error -select_streams v:0 -show_entries stream=width,height -of csv=s=x:p=0 input.mp4

例如,如果你想从一个1280x720的视频中裁剪出一个宽度为640,高度为480的视频片段,并且裁剪区域的左上角起始于位置(200, 100),命令应该这样写:

ffmpeg -i input.mp4 -filter:v “crop=640:480:200:100” output.mp4

两个视频视频帧像素融合

如果你想要将两个视频的帧像素进行融合,可以使用FFmpeg的"blend"过滤器。下面是一个示例命令,展示了如何使用FFmpeg将两个视频的帧像素进行融合:

ffmpeg -i input1.mp4 -i input2.mp4 -filter_complex "[0:v][1:v]blend=all_expr='A*(if(gte(T,2),1,T/2))+B*(1-(if(gte(T,2),1,T/2)))'" output.mp4

这个命令假设你有两个输入文件,分别命名为input1.mp4和input2.mp4。命令会将两个视频的帧像素进行融合,并将输出保存为output.mp4。

你需要替换示例命令中的输入文件名和输出文件名,以适应你自己的文件。

在示例命令中,-filter_complex选项指定了复杂的过滤器图表。我们使用了"blend"过滤器,并通过表达式all_expr控制了帧像素的融合方式。

在这个示例中,我们使用了一个简单的线性混合表达式:

A*(if(gte(T,2),1,T/2))+B*(1-(if(gte(T,2),1,T/2)))

其中,A代表第一个输入视频的像素值,B代表第二个输入视频的像素值,T代表当前帧的时间。这个表达式的意思是,如果时间大于等于2秒,则完全显示第一个视频的像素值,否则将两个视频的像素按比例混合。

请注意,两个视频的分辨率和帧率应该是相同的,以便能够正确进行帧像素的融合

FFMPEG学习整理(FFMPEG官网)

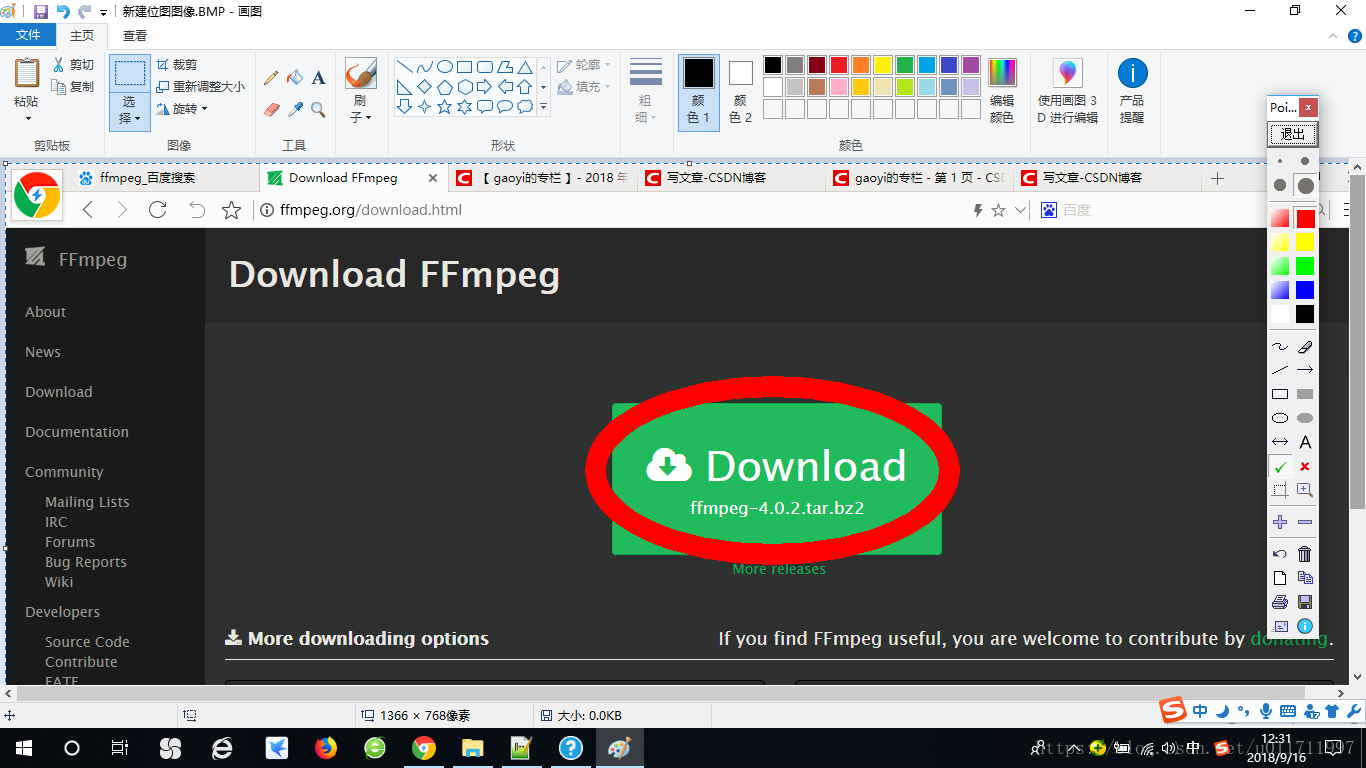

FFMPEG下载

在 windows 环境,FFmpeg 有两个网址可以下载安装包。

0.点击进入官网

20230314重头来

一、ffmpeg介绍

文章最后有福利

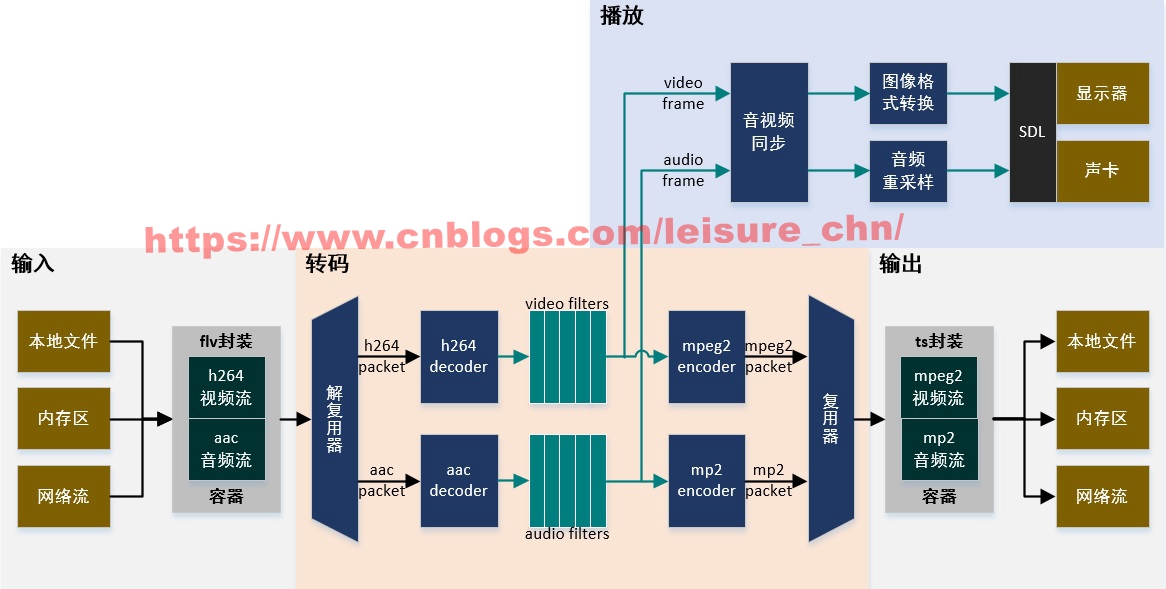

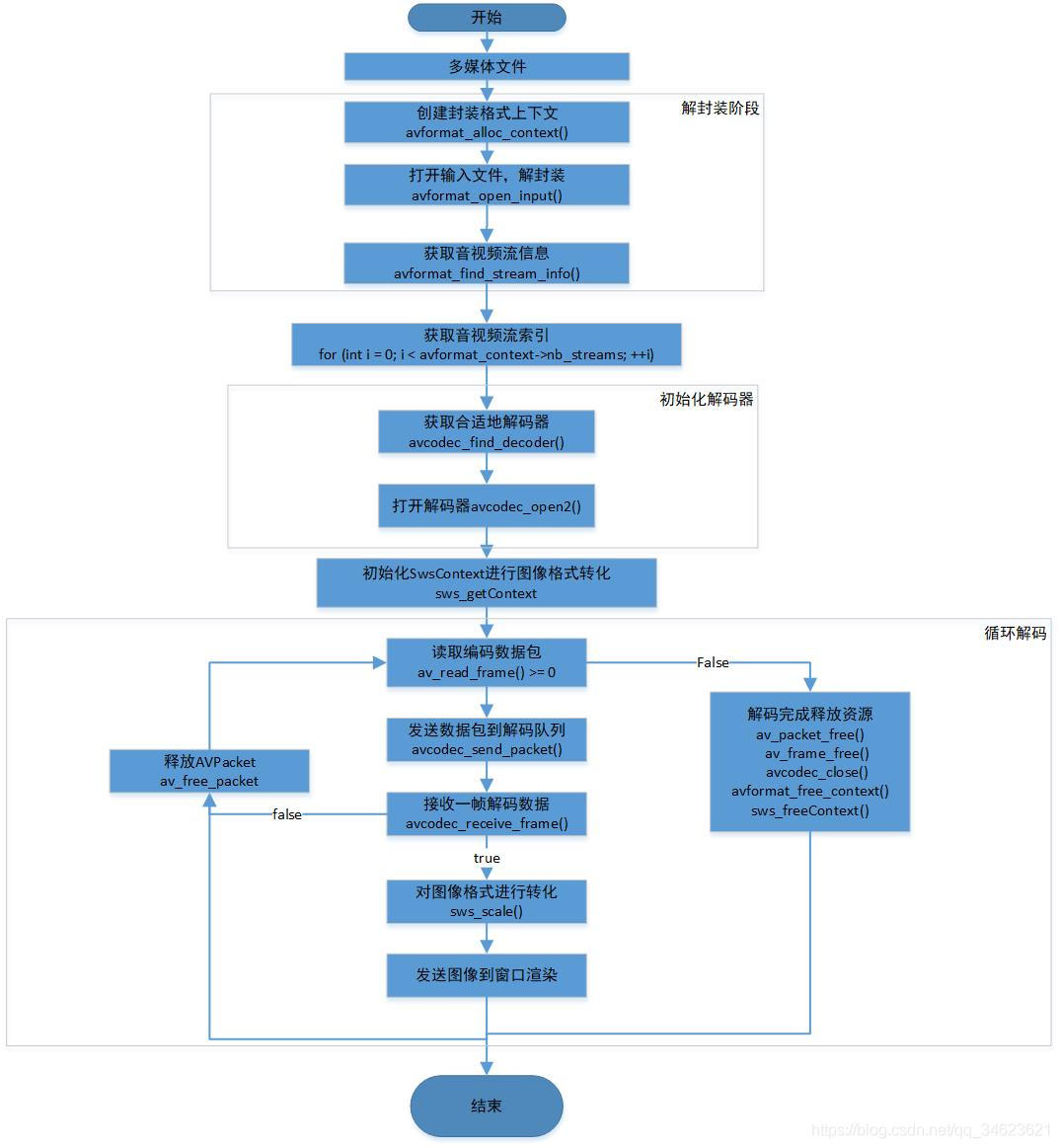

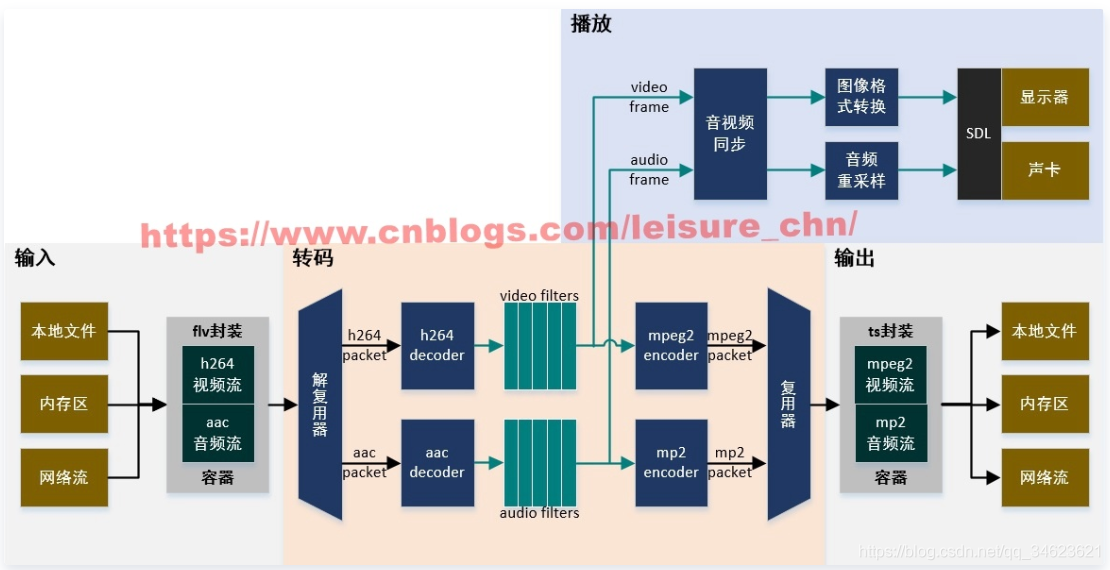

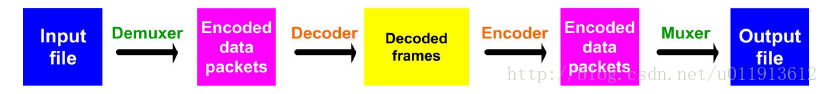

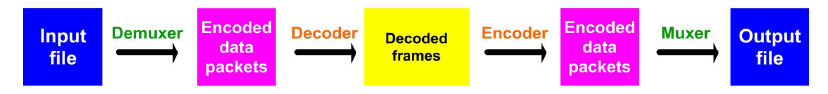

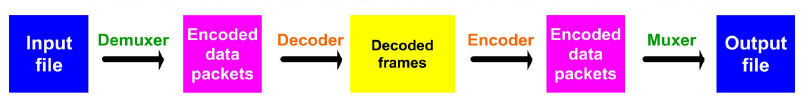

FFmpeg是一套可以用来记录、转换数字音频、视频,并能将其转化为流的开源计算机程序。采用LGPL或GPL许可证。它提供了录制、转换以及流化音视频的完整解决方案。它包含了非常先进的音频/视频编解码库libavcodec,为了保证高可移植性和编解码质量,libavcodec里很多code都是从头开发的。

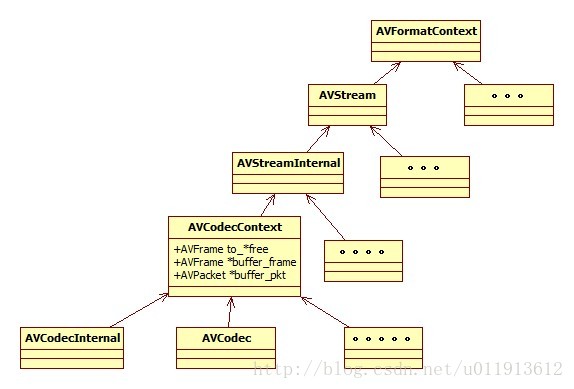

框图如图所示:

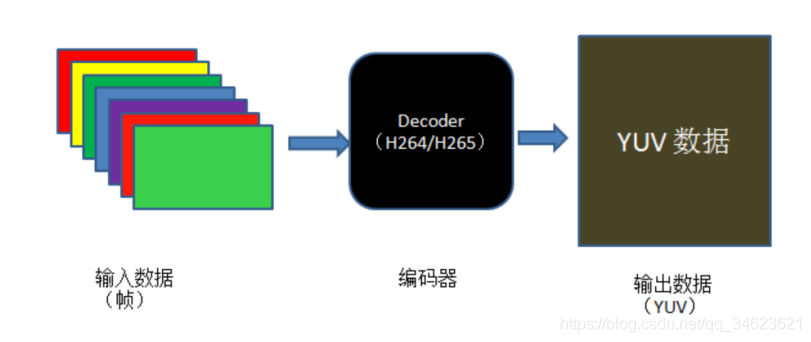

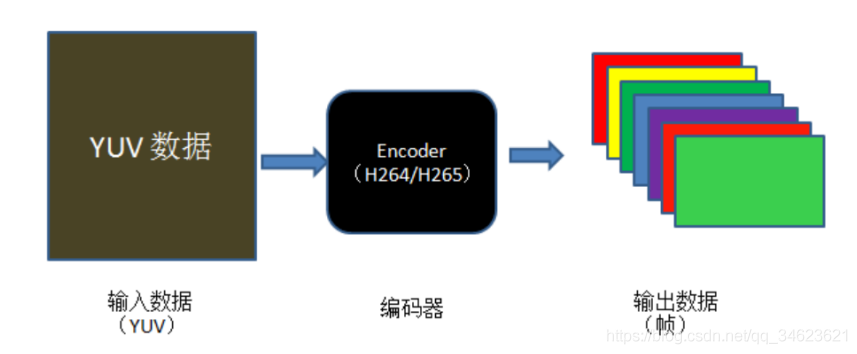

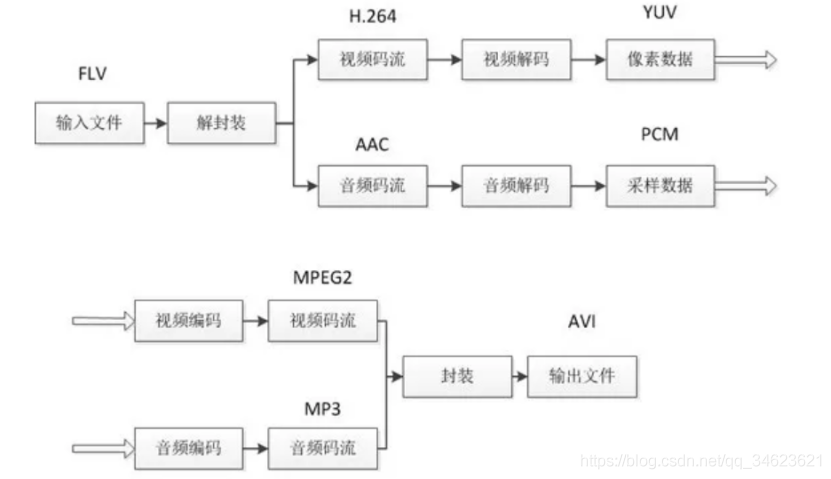

二、编解码基础知识

(1)封装格式

所谓封装格式是指音视频的组合格式,例如最常见的封装格式有mp4、mp3、flv等。简单来说,我们平时接触到的带有后缀的音视频文件都是一种封装格式。

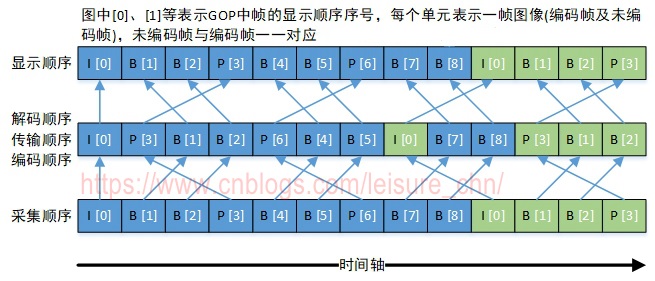

(2)编码格式

以mp4为例,通常应该包含有视频和音频。视频的编码格式为YUV420P,音频的编码格式为PCM。再以YUV420编码格式为例。我们知道通常图像的显示为RGB(红绿蓝三原色),在视频压缩的时候会首先将代表每一帧画面的RGB压缩为YUV,再按照关键帧(I帧),过渡帧(P帧或B帧)进行运算和编码。解码的过程正好相反,解码器会读到I帧,并根据I帧运算和解码P帧以及B帧。并最终根据视频文件预设的FPS还原每一帧画面的RGB数据。最后推送给显卡。所以通常我们说的编码过程就包括:画面采集、转码、编码再封装。

(3)视频解码和音频解码有什么区别

FPS是图像领域中的定义,是指画面每秒传输帧数,通俗来讲就是指动画或视频的画面数。FPS太低画面会感觉闪烁不够连贯,FPS越高需要显卡性能越好。一些高速摄像机的采集速度能够达到11000帧/秒,那么在播放这类影片的时候我们是否也需要以11000帧/秒播放呢?当然不是,通常我们会按照25帧/秒或者60帧/秒设定图像的FPS值。但是由于视频存在关键帧和过渡帧的区别,关键帧保存了完整的画面而过渡帧只是保存了与前一帧画面的变化部分,需要通过关键帧计算获得。因此我们需要对每一帧都进行解码,即获取画面的YUV数据。同时只对我们真正需要显示的画面进行转码,即将YUV数据转换成RGB数据,包括计算画面的宽高等。

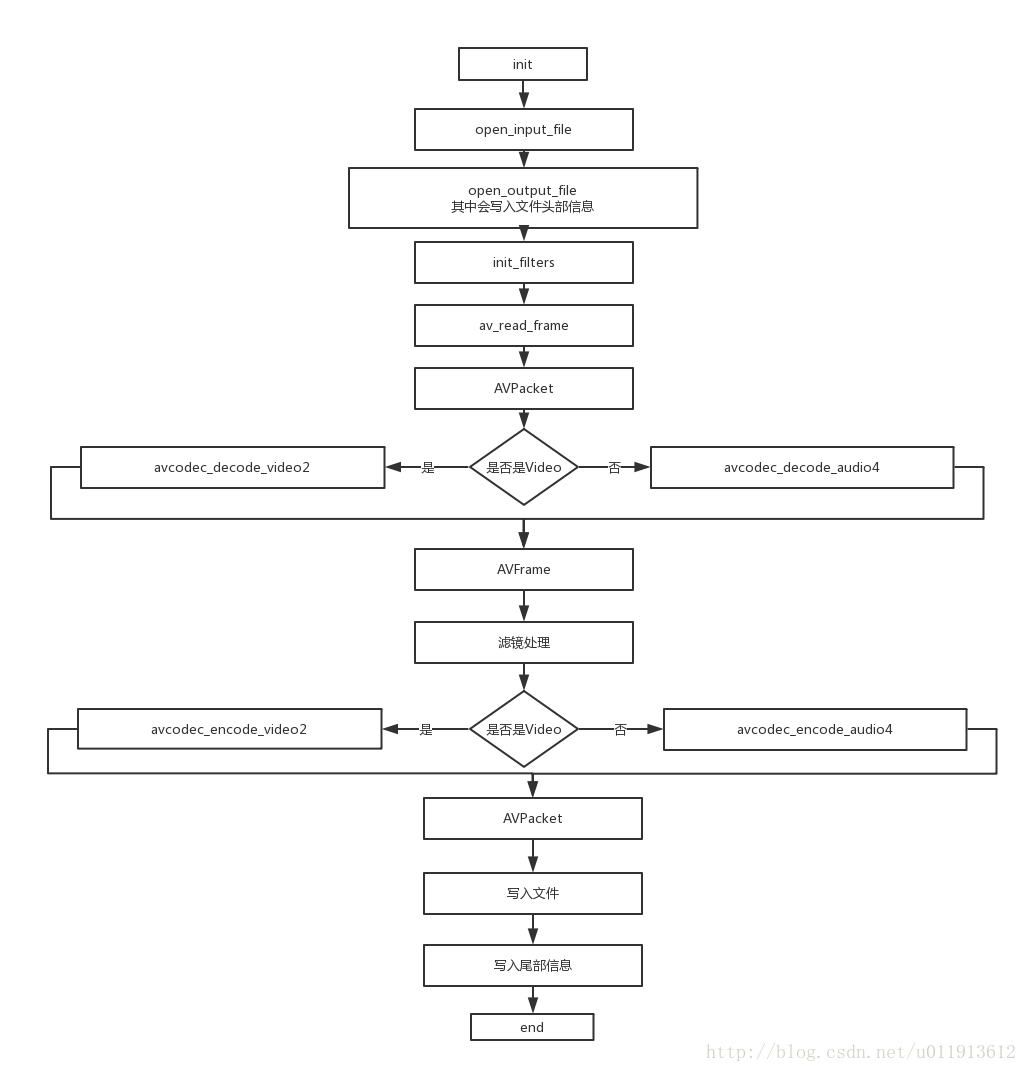

三、代码实现

(1)注册FFmpeg组件

//注册和初始化FFmpeg封装器和网络设备

(2)打开文件和创建输入设备

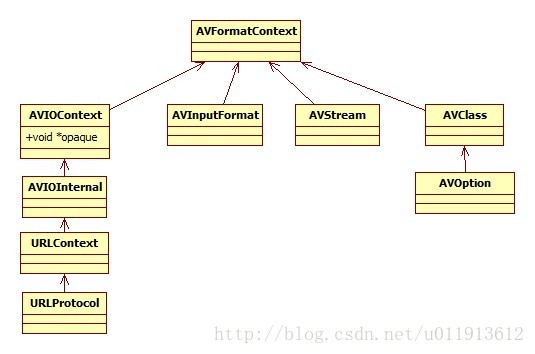

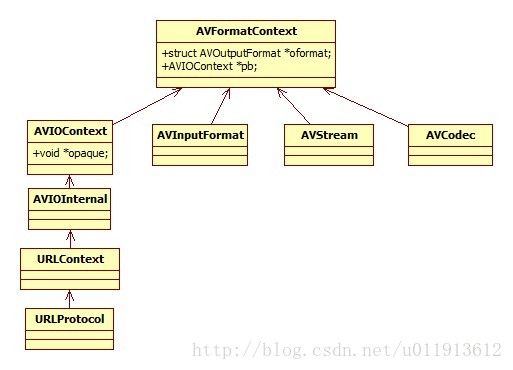

AVFormatContext 表示一个封装器,

在读取多媒体文件的时候,它负责保存与封装和编解码有关的上下文信息。

(3)遍历流并初始化解码器

封装器中保存了各种流媒体的通道,通常视频通道为0,音频通道为1。

除此以外可能还包含字幕流通道等。

第2步和第3步基本就是打开多媒体文件的主要步骤,

解码和转码的所有参数都可以在这里获取。

接下来我们就需要循环进行读取、解码、转码直到播放完成。

(4)读取压缩数据

/*之所以称为压缩数据主要是为了区分AVPacket和AVFrame两个结构体。

AVPacket表示一幅经过了关键帧或过渡帧编码后的画面,

AVFrame表示一个AVPacket经过解码后的完整YUV画面*/

(5)解码

(6)视频转码

// 720p输出标准

/*

这里需要解释一下outWidth * outHeight * 4计算理由:

720p标准的视频画面包含720 * 480个像素点,

每一个像素点包含了RGBA4类数据,每一类数据分别由1个byte即8个bit表示。

因此一幅完整画面所占的大小为outWidth * outHeight * 4。

(7)音频转码

四、代码地址

基于qt的FFmpeg客户端(Linux版本):

服务端可采用LIVE555服务器 ,参考博文:

1.1ffmpeg程序的使用

FFmpeg项目由以下几部分组成:

- FFmpeg视频文件转换命令行工具,也支持经过实时电视卡抓取和编码成视频文件;

- ffserver基于HTTP、RTSP用于实时广播的多媒体服务器.也支持时间平移;

- ffplay用 SDL和FFmpeg库开发的一个简单的媒体播放器;

- libavcodec一个包含了所有FFmpeg音视频编解码器的库。为了保证最优性能和高可复用性,大多数编解码器从头开发的;

- libavformat一个包含了所有的普通音视格式的解析器和产生器的库。

1.2 谁在使用ffmpeg

- 使用FFMPEG作为内核视频播放器:Mplayer,ffplay,射手播放器,暴风影音,KMPlayer,QQ影音...

- 使用FFMPEG作为内核的Directshow Filter:ffdshow,lav filters...

- 使用FFMPEG作为内核的转码工具:ffmpeg,格式工厂...

2.如何安装

FFmpeg可以在Windows、Linux还有Mac OS等多种操作系统中进行安装和使用。

FFmpeg分为3个版本:Static、 Shared、 Dev

- 前两个版本可以直接在命令行中使用。包含了三个exe:ffmpeg.exe,ffplay.exe,ffprobe.exe

- Static版本中的exe体积较大,那是因为相关的Dll都已经编译进exe里面去了。

- Shared版本中exe的体积相对小很多,是因为它们运行的时候还需要到相关的dll中调用相应的功能

- Dev版本用于开发,里面包含了库文件xxx.lib以及头文件xxx.h

3.怎么使用

3.1 命令行工具的使用

3.11 ffmpeg.exe

3.12 ffplay.exe

主要用于播放的应用程序

3.13 ffprobe.exe

ffprobe是用于查看文件格式的应用程序。

总结说明

常用API函数

1、注册、初始化相关函数

avdevice_register_all():对设备进行注册,如V4L2。

avformat_network_init():初始化网络库,以及网络加密协议相关的库,如openSSL。

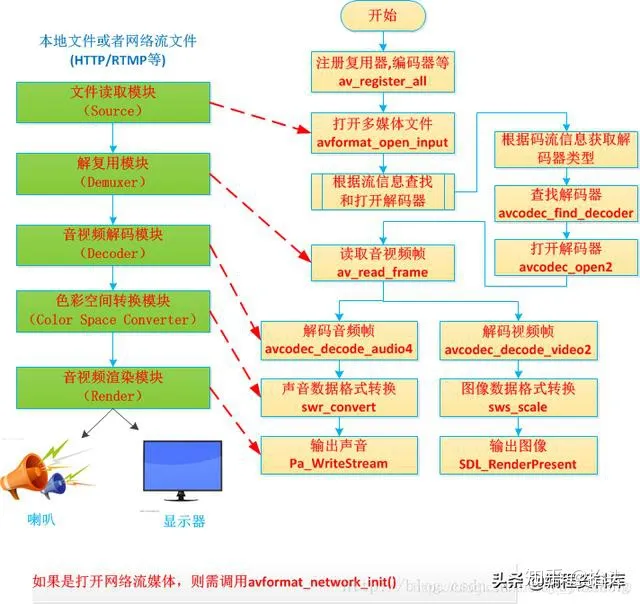

2、封装格式相关函数

avformat_alloc_context():申请一个AVFormatContext结构的内存,并进行简单初始化。

avformat_free_context():释放AVFormatContext结构的内存。

avformat_close_input():关闭解复用器;关闭后就不再需要使用avformat_free_context()进行释放。

avformat_open_input(AVFormatContext **ps, const char *url, ff_const59 AVInputFormat *fmt, AVDictionary **options):打开输入视频文件。

参数说明:

AVFormatContext **ps, 格式化的上下文。要注意,如果传入的是一个AVFormatContext*的指针,则该空间须自己手动清理,若传入的指针为空,则FFmpeg会内部自己创建。

const char *filename, 传入的文件地址。支持http,RTSP,以及普通的本地文件。地址最终会存入到AVFormatContext结构体当中。

AVInputFormat *fmt, 指定输入的封装格式。一般传NULL,由FFmpeg自行探测。

AVDictionary **options, 其它参数设置。它是一个字典,用于参数传递,不传则写NULL);

avformat_find_stream_info():获取音视频文件信息。

av_read_frame():读取音视频包。

avformat_seek_file():定位文件。

av_seek_frame():定位文件。

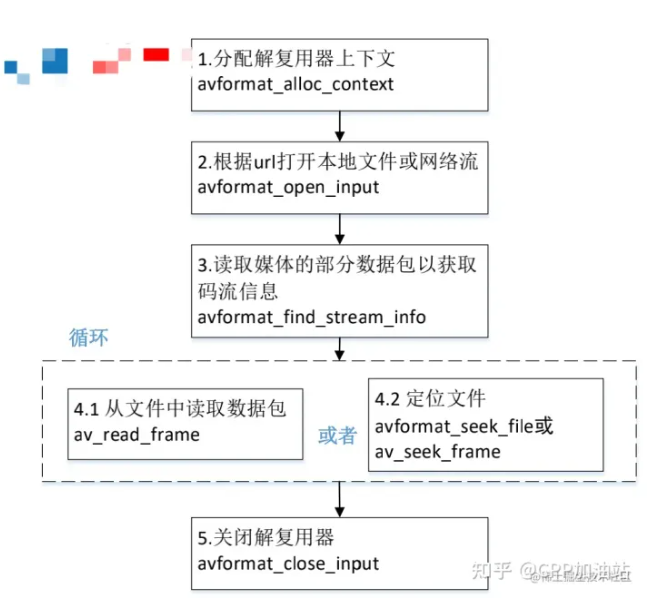

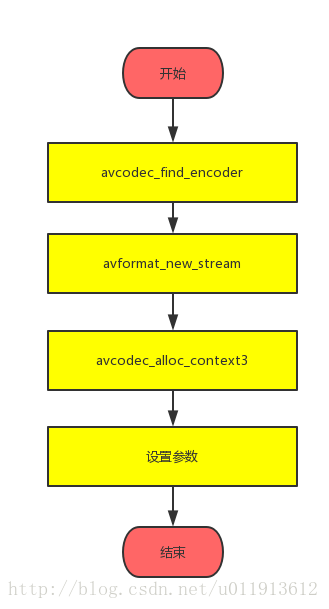

封装应用流程

3、解码器相关函数

avcodec_alloc_context3():分配解码器上下文。

avcodec_find_decoder():根据ID查找解码器。

avcodec_find_decoder_by_name():根据解码器名字查找解码器。

avcodec_open2():打开编解码器。

avcodec_send_packet():发送给编码数据包。

avcodec_receive_frame():接收解码后数据。

avcodec_free_context():释放解码器上下文,包含了avcodec_close()。

avcodec_close():关闭解码器。

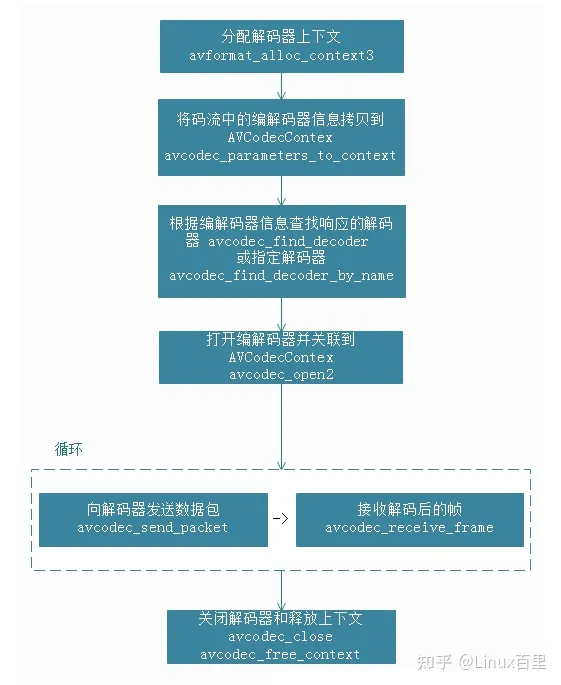

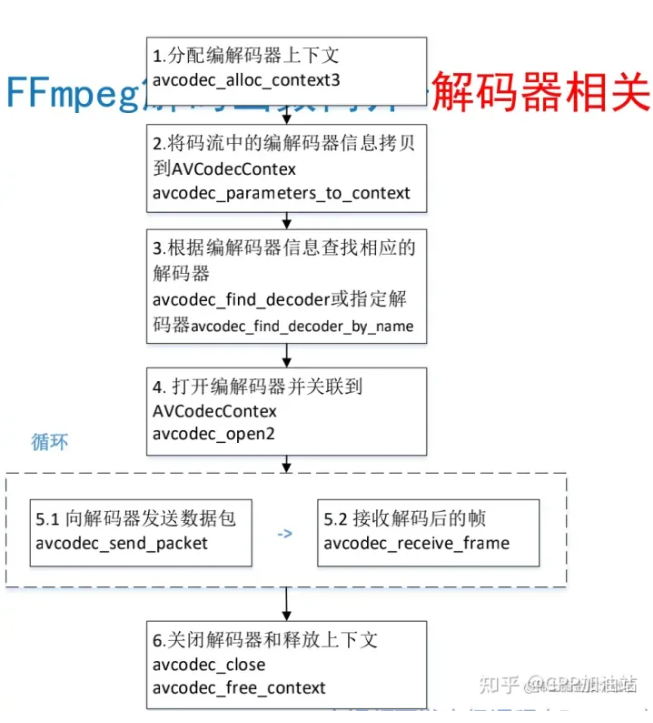

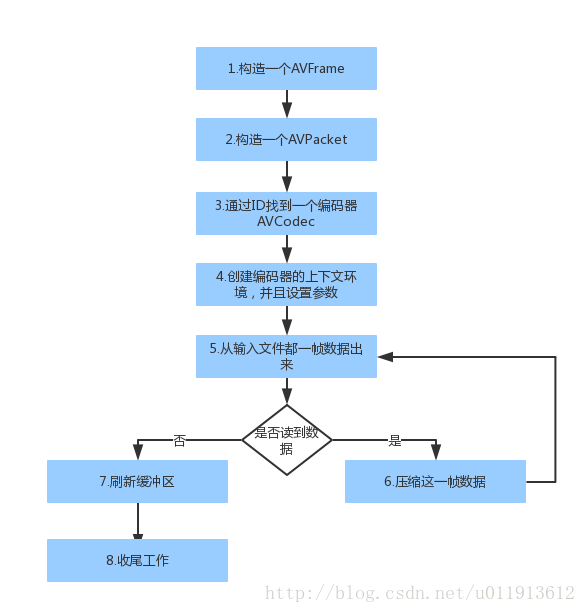

解码应用流程

常用数据结构

1、AVFormatContext

封装格式上下文结构体,也是统领全局的结构体,保存了视频文件封装格式相关信息。

iformat:输入媒体的AVInputFormat,比如指向AVInputFormat ff_flv_demuxer

nb_streams:输入媒体的AVStream 个数

streams:输入媒体的AVStream []数组

duration:输入媒体的时长(以微秒为单位),计算方式可以参考av_dump_format()函数。

bit_rate:输入媒体的码率

2、AVInputFormat

每种封装格式(例如FLV, MKV, MP4, AVI)对应一个该结构体。

name:封装格式名称

extensions:封装格式的扩展名

id:封装格式ID

一些封装格式处理的接口函数,比如read_packet()

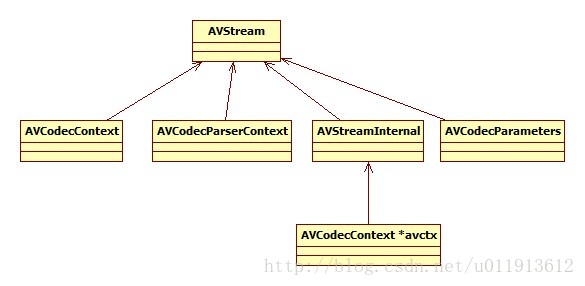

3、AVStream

视频文件中每个视频(音频)流对应一个该结构体。

index:标识该视频/音频流

time_base:该流的时基, PTS*time_base=真正的时间(秒)

avg_frame_rate: 该流的帧率

duration:该视频/音频流长度

codecpar:编解码器参数属性

4、AVCodecParameters

codec_type:媒体类型,比如AVMEDIA_TYPE_VIDEO AVMEDIA_TYPE_AUDIO等

codec_id:编解码器类型, 比如AV_CODEC_ID_H264AV_CODEC_ID_AAC等。

5、AVCodecContext

编解码器上下文结构体,保存了视频(音频)编解码相关信息。

codec:编解码器的AVCodec,比如指向AVCodec ff_aac_latm_decoder

width, height:图像的宽高(只针对视频)

pix_fmt:像素格式(只针对视频)

sample_rate:采样率(只针对音频)

channels:声道数(只针对音频)

sample_fmt:采样格式(只针对音频)

6、AVCodec

每种视频(音频)编解码器(例如H.264解码器)对应一个该结构体。

name:编解码器名称

type:编解码器类型

id:编解码器ID

一些编解码的接口函数,比如int (*decode)()

7、AVPacket

存储一帧压缩编码数据。

pts:显示时间戳

dts:解码时间戳

data:压缩编码数据

size:压缩编码数据大小

pos:数据的偏移地址

stream_index:所属的AVStream

8、AVFrame

存储一帧解码后像素(采样)数据。

data:解码后的图像像素数据(音频采样数据)

linesize:对视频来说是图像中一行像素的大小;对音频来说是整个音频帧的大小

width, height:图像的宽高(只针对视频)

key_frame:是否为关键帧(只针对视频) 。

pict_type:帧类型(只针对视频) 。例如I, P, B

sample_rate:音频采样率(只针对音频)

nb_samples:音频每通道采样数(只针对音频)

pts:显示时间戳

9、AVOutputFormat

1)描述

AVOutputFormat 表示输出文件容器格式,AVOutputFormat结构主要包含的信息有:

封装名称描述

编码格式信息(video/audio 默认编码格式,支持的编码格式列表)

对封装的操作函数(write_header,write_packet,write_tailer等)

ffmpeg支持各种各样的输出文件格式,MP4,FLV,3GP等。

AVOutputFormat结构保存了这些格式的信息和一些常规设置。

解压

static void decode(AVCodecContext *dec_ctx, AVFrame *frame, AVPacket *pkt,

const char *filename)

{

char buf[1024];

int ret;

ret = avcodec_send_packet(dec_ctx, pkt);

if (ret < 0) {

fprintf(stderr, "Error sending a packet for decoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_frame(dec_ctx, frame);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during decoding\n");

exit(1);

}

printf("saving frame %3d\n", dec_ctx->frame_number);

fflush(stdout);

/* the picture is allocated by the decoder. no need to

free it */

snprintf(buf, sizeof(buf), "%s-%d", filename, dec_ctx->frame_number);

pgm_save(frame->data[0], frame->linesize[0],

frame->width, frame->height, buf);

}

}

压缩:

static void encode(AVCodecContext *enc_ctx, AVFrame *frame, AVPacket *pkt,

FILE *outfile)

{

int ret;

/* send the frame to the encoder */

if (frame)

printf("Send frame %3"PRId64"\n", frame->pts);

ret = avcodec_send_frame(enc_ctx, frame);

if (ret < 0) {

fprintf(stderr, "Error sending a frame for encoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_packet(enc_ctx, pkt);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during encoding\n");

exit(1);

}

printf("Write packet %3"PRId64" (size=%5d)\n", pkt->pts, pkt->size);

fwrite(pkt->data, 1, pkt->size, outfile);

av_packet_unref(pkt);

}

}

视频解压

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <libavcodec/avcodec.h>

#define INBUF_SIZE 4096

static void pgm_save(unsigned char *buf, int wrap, int xsize, int ysize,

char *filename)

{

FILE *f;

int i;

f = fopen(filename,"w");

fprintf(f, "P5\n%d %d\n%d\n", xsize, ysize, 255);

for (i = 0; i < ysize; i++)

fwrite(buf + i * wrap, 1, xsize, f);

fclose(f);

}

static void decode(AVCodecContext *dec_ctx, AVFrame *frame, AVPacket *pkt,

const char *filename)

{

char buf[1024];

int ret;

ret = avcodec_send_packet(dec_ctx, pkt);

if (ret < 0) {

fprintf(stderr, "Error sending a packet for decoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_frame(dec_ctx, frame);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during decoding\n");

exit(1);

}

printf("saving frame %3d\n", dec_ctx->frame_number);

fflush(stdout);

/* the picture is allocated by the decoder. no need to

free it */

snprintf(buf, sizeof(buf), "%s-%d", filename, dec_ctx->frame_number);

pgm_save(frame->data[0], frame->linesize[0],

frame->width, frame->height, buf);

}

}

int main(int argc, char **argv)

{

const char *filename, *outfilename;

const AVCodec *codec;

AVCodecParserContext *parser;

AVCodecContext *c= NULL;

FILE *f;

AVFrame *frame;

uint8_t inbuf[INBUF_SIZE + AV_INPUT_BUFFER_PADDING_SIZE];

uint8_t *data;

size_t data_size;

int ret;

AVPacket *pkt;

if (argc <= 2) {

fprintf(stderr, "Usage: %s <input file> <output file>\n"

"And check your input file is encoded by mpeg1video please.\n", argv[0]);

exit(0);

}

filename = argv[1];

outfilename = argv[2];

pkt = av_packet_alloc();

if (!pkt)

exit(1);

/* set end of buffer to 0 (this ensures that no overreading happens for damaged MPEG streams) */

memset(inbuf + INBUF_SIZE, 0, AV_INPUT_BUFFER_PADDING_SIZE);

/* find the MPEG-1 video decoder */

codec = avcodec_find_decoder(AV_CODEC_ID_MPEG1VIDEO);

if (!codec) {

fprintf(stderr, "Codec not found\n");

exit(1);

}

parser = av_parser_init(codec->id);

if (!parser) {

fprintf(stderr, "parser not found\n");

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate video codec context\n");

exit(1);

}

/* For some codecs, such as msmpeg4 and mpeg4, width and height

MUST be initialized there because this information is not

available in the bitstream. */

/* open it */

if (avcodec_open2(c, codec, NULL) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}

f = fopen(filename, "rb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

frame = av_frame_alloc();

if (!frame) {

fprintf(stderr, "Could not allocate video frame\n");

exit(1);

}

while (!feof(f)) {

/* read raw data from the input file */

data_size = fread(inbuf, 1, INBUF_SIZE, f);

if (!data_size)

break;

/* use the parser to split the data into frames */

data = inbuf;

while (data_size > 0) {

ret = av_parser_parse2(parser, c, &pkt->data, &pkt->size,

data, data_size, AV_NOPTS_VALUE, AV_NOPTS_VALUE, 0);

if (ret < 0) {

fprintf(stderr, "Error while parsing\n");

exit(1);

}

data += ret;

data_size -= ret;

if (pkt->size)

decode(c, frame, pkt, outfilename);

}

}

/* flush the decoder */

decode(c, frame, NULL, outfilename);

fclose(f);

av_parser_close(parser);

avcodec_free_context(&c);

av_frame_free(&frame);

av_packet_free(&pkt);

return 0;

}

音频解压

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <libavutil/frame.h>

#include <libavutil/mem.h>

#include <libavcodec/avcodec.h>

#define AUDIO_INBUF_SIZE 20480

#define AUDIO_REFILL_THRESH 4096

static int get_format_from_sample_fmt(const char **fmt,

enum AVSampleFormat sample_fmt)

{

int i;

struct sample_fmt_entry {

enum AVSampleFormat sample_fmt; const char *fmt_be, *fmt_le;

} sample_fmt_entries[] = {

{ AV_SAMPLE_FMT_U8, "u8", "u8" },

{ AV_SAMPLE_FMT_S16, "s16be", "s16le" },

{ AV_SAMPLE_FMT_S32, "s32be", "s32le" },

{ AV_SAMPLE_FMT_FLT, "f32be", "f32le" },

{ AV_SAMPLE_FMT_DBL, "f64be", "f64le" },

};

*fmt = NULL;

for (i = 0; i < FF_ARRAY_ELEMS(sample_fmt_entries); i++) {

struct sample_fmt_entry *entry = &sample_fmt_entries[i];

if (sample_fmt == entry->sample_fmt) {

*fmt = AV_NE(entry->fmt_be, entry->fmt_le);

return 0;

}

}

fprintf(stderr,

"sample format %s is not supported as output format\n",

av_get_sample_fmt_name(sample_fmt));

return -1;

}

static void decode(AVCodecContext *dec_ctx, AVPacket *pkt, AVFrame *frame,

FILE *outfile)

{

int i, ch;

int ret, data_size;

/* send the packet with the compressed data to the decoder */

ret = avcodec_send_packet(dec_ctx, pkt);

if (ret < 0) {

fprintf(stderr, "Error submitting the packet to the decoder\n");

exit(1);

}

/* read all the output frames (in general there may be any number of them */

while (ret >= 0) {

ret = avcodec_receive_frame(dec_ctx, frame);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during decoding\n");

exit(1);

}

data_size = av_get_bytes_per_sample(dec_ctx->sample_fmt);

if (data_size < 0) {

/* This should not occur, checking just for paranoia */

fprintf(stderr, "Failed to calculate data size\n");

exit(1);

}

for (i = 0; i < frame->nb_samples; i++)

for (ch = 0; ch < dec_ctx->channels; ch++)

fwrite(frame->data[ch] + data_size*i, 1, data_size, outfile);

}

}

int main(int argc, char **argv)

{

const char *outfilename, *filename;

const AVCodec *codec;

AVCodecContext *c= NULL;

AVCodecParserContext *parser = NULL;

int len, ret;

FILE *f, *outfile;

uint8_t inbuf[AUDIO_INBUF_SIZE + AV_INPUT_BUFFER_PADDING_SIZE];

uint8_t *data;

size_t data_size;

AVPacket *pkt;

AVFrame *decoded_frame = NULL;

enum AVSampleFormat sfmt;

int n_channels = 0;

const char *fmt;

if (argc <= 2) {

fprintf(stderr, "Usage: %s <input file> <output file>\n", argv[0]);

exit(0);

}

filename = argv[1];

outfilename = argv[2];

pkt = av_packet_alloc();

/* find the MPEG audio decoder */

codec = avcodec_find_decoder(AV_CODEC_ID_MP2);

if (!codec) {

fprintf(stderr, "Codec not found\n");

exit(1);

}

parser = av_parser_init(codec->id);

if (!parser) {

fprintf(stderr, "Parser not found\n");

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate audio codec context\n");

exit(1);

}

/* open it */

if (avcodec_open2(c, codec, NULL) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}

f = fopen(filename, "rb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

outfile = fopen(outfilename, "wb");

if (!outfile) {

av_free(c);

exit(1);

}

/* decode until eof */

data = inbuf;

data_size = fread(inbuf, 1, AUDIO_INBUF_SIZE, f);

while (data_size > 0) {

if (!decoded_frame) {

if (!(decoded_frame = av_frame_alloc())) {

fprintf(stderr, "Could not allocate audio frame\n");

exit(1);

}

}

ret = av_parser_parse2(parser, c, &pkt->data, &pkt->size,

data, data_size,

AV_NOPTS_VALUE, AV_NOPTS_VALUE, 0);

if (ret < 0) {

fprintf(stderr, "Error while parsing\n");

exit(1);

}

data += ret;

data_size -= ret;

if (pkt->size)

decode(c, pkt, decoded_frame, outfile);

if (data_size < AUDIO_REFILL_THRESH) {

memmove(inbuf, data, data_size);

data = inbuf;

len = fread(data + data_size, 1,

AUDIO_INBUF_SIZE - data_size, f);

if (len > 0)

data_size += len;

}

}

/* flush the decoder */

pkt->data = NULL;

pkt->size = 0;

decode(c, pkt, decoded_frame, outfile);

/* print output pcm infomations, because there have no metadata of pcm */

sfmt = c->sample_fmt;

if (av_sample_fmt_is_planar(sfmt)) {

const char *packed = av_get_sample_fmt_name(sfmt);

printf("Warning: the sample format the decoder produced is planar "

"(%s). This example will output the first channel only.\n",

packed ? packed : "?");

sfmt = av_get_packed_sample_fmt(sfmt);

}

n_channels = c->channels;

if ((ret = get_format_from_sample_fmt(&fmt, sfmt)) < 0)

goto end;

printf("Play the output audio file with the command:\n"

"ffplay -f %s -ac %d -ar %d %s\n",

fmt, n_channels, c->sample_rate,

outfilename);

end:

fclose(outfile);

fclose(f);

avcodec_free_context(&c);

av_parser_close(parser);

av_frame_free(&decoded_frame);

av_packet_free(&pkt);

return 0;

}

视频压缩

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <libavcodec/avcodec.h>

#include <libavutil/opt.h>

#include <libavutil/imgutils.h>

static void encode(AVCodecContext *enc_ctx, AVFrame *frame, AVPacket *pkt,

FILE *outfile)

{

int ret;

/* send the frame to the encoder */

if (frame)

printf("Send frame %3"PRId64"\n", frame->pts);

ret = avcodec_send_frame(enc_ctx, frame);

if (ret < 0) {

fprintf(stderr, "Error sending a frame for encoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_packet(enc_ctx, pkt);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during encoding\n");

exit(1);

}

printf("Write packet %3"PRId64" (size=%5d)\n", pkt->pts, pkt->size);

fwrite(pkt->data, 1, pkt->size, outfile);

av_packet_unref(pkt);

}

}

int main(int argc, char **argv)

{

const char *filename, *codec_name;

const AVCodec *codec;

AVCodecContext *c= NULL;

int i, ret, x, y;

FILE *f;

AVFrame *frame;

AVPacket *pkt;

uint8_t endcode[] = { 0, 0, 1, 0xb7 };

if (argc <= 2) {

fprintf(stderr, "Usage: %s <output file> <codec name>\n", argv[0]);

exit(0);

}

filename = argv[1];

codec_name = argv[2];

/* find the mpeg1video encoder */

codec = avcodec_find_encoder_by_name(codec_name);

if (!codec) {

fprintf(stderr, "Codec '%s' not found\n", codec_name);

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate video codec context\n");

exit(1);

}

pkt = av_packet_alloc();

if (!pkt)

exit(1);

/* put sample parameters */

c->bit_rate = 400000;

/* resolution must be a multiple of two */

c->width = 352;

c->height = 288;

/* frames per second */

c->time_base = (AVRational){1, 25};

c->framerate = (AVRational){25, 1};

/* emit one intra frame every ten frames

* check frame pict_type before passing frame

* to encoder, if frame->pict_type is AV_PICTURE_TYPE_I

* then gop_size is ignored and the output of encoder

* will always be I frame irrespective to gop_size

*/

c->gop_size = 10;

c->max_b_frames = 1;

c->pix_fmt = AV_PIX_FMT_YUV420P;

if (codec->id == AV_CODEC_ID_H264)

av_opt_set(c->priv_data, "preset", "slow", 0);

/* open it */

ret = avcodec_open2(c, codec, NULL);

if (ret < 0) {

fprintf(stderr, "Could not open codec: %s\n", av_err2str(ret));

exit(1);

}

f = fopen(filename, "wb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

frame = av_frame_alloc();

if (!frame) {

fprintf(stderr, "Could not allocate video frame\n");

exit(1);

}

frame->format = c->pix_fmt;

frame->width = c->width;

frame->height = c->height;

ret = av_frame_get_buffer(frame, 32);

if (ret < 0) {

fprintf(stderr, "Could not allocate the video frame data\n");

exit(1);

}

/* encode 1 second of video */

for (i = 0; i < 25; i++) {

fflush(stdout);

/* make sure the frame data is writable */

ret = av_frame_make_writable(frame);

if (ret < 0)

exit(1);

/* prepare a dummy image */

/* Y */

for (y = 0; y < c->height; y++) {

for (x = 0; x < c->width; x++) {

frame->data[0][y * frame->linesize[0] + x] = x + y + i * 3;

}

}

/* Cb and Cr */

for (y = 0; y < c->height/2; y++) {

for (x = 0; x < c->width/2; x++) {

frame->data[1][y * frame->linesize[1] + x] = 128 + y + i * 2;

frame->data[2][y * frame->linesize[2] + x] = 64 + x + i * 5;

}

}

frame->pts = i;

/* encode the image */

encode(c, frame, pkt, f);

}

/* flush the encoder */

encode(c, NULL, pkt, f);

/* add sequence end code to have a real MPEG file */

if (codec->id == AV_CODEC_ID_MPEG1VIDEO || codec->id == AV_CODEC_ID_MPEG2VIDEO)

fwrite(endcode, 1, sizeof(endcode), f);

fclose(f);

avcodec_free_context(&c);

av_frame_free(&frame);

av_packet_free(&pkt);

return 0;

}

音频压缩

#include <stdint.h>

#include <stdio.h>

#include <stdlib.h>

#include <libavcodec/avcodec.h>

#include <libavutil/channel_layout.h>

#include <libavutil/common.h>

#include <libavutil/frame.h>

#include <libavutil/samplefmt.h>

/* check that a given sample format is supported by the encoder */

static int check_sample_fmt(const AVCodec *codec, enum AVSampleFormat sample_fmt)

{

const enum AVSampleFormat *p = codec->sample_fmts;

while (*p != AV_SAMPLE_FMT_NONE) {

if (*p == sample_fmt)

return 1;

p++;

}

return 0;

}

/* just pick the highest supported samplerate */

static int select_sample_rate(const AVCodec *codec)

{

const int *p;

int best_samplerate = 0;

if (!codec->supported_samplerates)

return 44100;

p = codec->supported_samplerates;

while (*p) {

if (!best_samplerate || abs(44100 - *p) < abs(44100 - best_samplerate))

best_samplerate = *p;

p++;

}

return best_samplerate;

}

/* select layout with the highest channel count */

static int select_channel_layout(const AVCodec *codec)

{

const uint64_t *p;

uint64_t best_ch_layout = 0;

int best_nb_channels = 0;

if (!codec->channel_layouts)

return AV_CH_LAYOUT_STEREO;

p = codec->channel_layouts;

while (*p) {

int nb_channels = av_get_channel_layout_nb_channels(*p);

if (nb_channels > best_nb_channels) {

best_ch_layout = *p;

best_nb_channels = nb_channels;

}

p++;

}

return best_ch_layout;

}

static void encode(AVCodecContext *ctx, AVFrame *frame, AVPacket *pkt,

FILE *output)

{

int ret;

/* send the frame for encoding */

ret = avcodec_send_frame(ctx, frame);

if (ret < 0) {

fprintf(stderr, "Error sending the frame to the encoder\n");

exit(1);

}

/* read all the available output packets (in general there may be any

* number of them */

while (ret >= 0) {

ret = avcodec_receive_packet(ctx, pkt);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error encoding audio frame\n");

exit(1);

}

fwrite(pkt->data, 1, pkt->size, output);

av_packet_unref(pkt);

}

}

int main(int argc, char **argv)

{

const char *filename;

const AVCodec *codec;

AVCodecContext *c= NULL;

AVFrame *frame;

AVPacket *pkt;

int i, j, k, ret;

FILE *f;

uint16_t *samples;

float t, tincr;

if (argc <= 1) {

fprintf(stderr, "Usage: %s <output file>\n", argv[0]);

return 0;

}

filename = argv[1];

/* find the MP2 encoder */

codec = avcodec_find_encoder(AV_CODEC_ID_MP2);

if (!codec) {

fprintf(stderr, "Codec not found\n");

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate audio codec context\n");

exit(1);

}

/* put sample parameters */

c->bit_rate = 64000;

/* check that the encoder supports s16 pcm input */

c->sample_fmt = AV_SAMPLE_FMT_S16;

if (!check_sample_fmt(codec, c->sample_fmt)) {

fprintf(stderr, "Encoder does not support sample format %s",

av_get_sample_fmt_name(c->sample_fmt));

exit(1);

}

/* select other audio parameters supported by the encoder */

c->sample_rate = select_sample_rate(codec);

c->channel_layout = select_channel_layout(codec);

c->channels = av_get_channel_layout_nb_channels(c->channel_layout);

/* open it */

if (avcodec_open2(c, codec, NULL) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}

f = fopen(filename, "wb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

/* packet for holding encoded output */

pkt = av_packet_alloc();

if (!pkt) {

fprintf(stderr, "could not allocate the packet\n");

exit(1);

}

/* frame containing input raw audio */

frame = av_frame_alloc();

if (!frame) {

fprintf(stderr, "Could not allocate audio frame\n");

exit(1);

}

frame->nb_samples = c->frame_size;

frame->format = c->sample_fmt;

frame->channel_layout = c->channel_layout;

/* allocate the data buffers */

ret = av_frame_get_buffer(frame, 0);

if (ret < 0) {

fprintf(stderr, "Could not allocate audio data buffers\n");

exit(1);

}

/* encode a single tone sound */

t = 0;

tincr = 2 * M_PI * 440.0 / c->sample_rate;

for (i = 0; i < 200; i++) {

/* make sure the frame is writable -- makes a copy if the encoder

* kept a reference internally */

ret = av_frame_make_writable(frame);

if (ret < 0)

exit(1);

samples = (uint16_t*)frame->data[0];

for (j = 0; j < c->frame_size; j++) {

samples[2*j] = (int)(sin(t) * 10000);

for (k = 1; k < c->channels; k++)

samples[2*j + k] = samples[2*j];

t += tincr;

}

encode(c, frame, pkt, f);

}

/* flush the encoder */

encode(c, NULL, pkt, f);

fclose(f);

av_frame_free(&frame);

av_packet_free(&pkt);

avcodec_free_context(&c);

return 0;

}

ffmpeg常用api介绍

av_log_set_callback

函数原型:

void av_log_set_callback(void(*)(void *, int, const char *, va_list) callback)

设置日志打印的回调。

av_log

函数原型:

void av_log(void* avcl, int level, const char *fmt, ...)

输出日志。

av_malloc

av_malloc()就是简单的封装了系统函数malloc(),并做了一些错误检查工作。

avformat_alloc_output_context2()

函数原型

int avformat_alloc_output_context2(AVFormatContext **ctx, AVOutputFormat * oformat, const char * format_name, const char * filename)

初始化一个用于输出的AVFormatContext结构体

avformat_network_init

全局地初始化网络组件,需要用到网络功能的时候需要调用。

av_register_all

初始化libavformat和注册所有的复用器和解复用器和协议。

如果不调用这个函数,可以使用av_register_input_format()和av_register_out_format()来选择支持的格式。

AVPacket

AVPacket是存储压缩编码数据的数据结构。

通常是解复用器的输出,然后被传递给解码器。或者是编码器的输出,然后被传递给复用器。

AVPacket.size:data的大小。

AVPacket.dts:解码时间戳。

AVPacket.stream_index:标识该AVPacket所属的视频/音频流。

av_copy_packet

函数原型:

int av_copy_packet(AVPacket * dst, const AVPacket * src)

复制packet,包含内容。

av_packet_unref

函数原型:

void av_packet_unref(AVPacket * pkt)

解除packet引用的buffer,并且将其余的字段重置为默认值。

AVCodecContext

这是一个描述解码器上下文的数据结构,包含了众多编解码器需要的参数信息。

AVCodec

存储编码器信息的结构体。

主要包含以下信息:

const char *name:编解码器的名字的简称

const char *long_name:编解码器名字的全称

enum AVMediaType type:指明了类型,是视频,音频,还是字幕

enum AVCodecID id:ID,不重复

const AVRational *supported_framerates:支持的帧率(仅视频)

const enum AVPixelFormat *pix_fmts:支持的像素格式(仅视频),如RGB24、YUV420P等。

const int *supported_samplerates:支持的采样率(仅音频)

const enum AVSampleFormat *sample_fmts:支持的采样格式(仅音频)

const uint64_t *channel_layouts:支持的声道数(仅音频)

int priv_data_size:私有数据的大小

avcodec_send_packet

将原始分组数据作为解码器的输入。

在函数内部,会拷贝相关的AVCodecContext结构变量,将这些结构变量应用到解码的每一个包。例如

AVCodecContext.skip_frame参数通知解码器扔掉包含该帧的包。

avcodec_alloc_context3()

创建AVCodecContext结构体。

avcodec_parameters_to_context

将音频流信息拷贝到新的AVCodecContext结构体中。

avcodec_free_context

释放AVCodecContext和与之相关联的所有内容,并且把指针置空。

avcodec_open2

原型:

int avcodec_open2(AVCodecContext *avctx, const AVCodec *codec, AVDictionary **options)

使用给定的AVCodec初始化AVCodecContext。

在使用这个函数之前需要使用avcodec_alloc_context3()分配的context。

av_frame_alloc

原型

AVFrame* av_frame_alloc(void)

分配一个avframe和设置字段的默认值。分配出来的AVFrame必须使用av_frame_free()释放。

avcodec_receive_frame

原型

int avcodec_receive_frame(AVCodecContext *avctx, AVFrame *frame)

返回解码器输出的解码数据

av_read_pause

原型

int av_read_pause(AVFormatContext *s)

暂停网络流(例如RSTP流),使用av_read_play()重新开始。

av_read_play

原型

int av_read_play(AVFrameContext *s)

从当前的位置开始播放网络流(例如RSTP流)。

av_seek_frame

原型

int av_seek_frame(AVFormatContext *s, int stream_index, int64_t timestamp, int flags)

seek到某个时间点的关键帧。

av_read_frame

原型

int av_read_frame(AVFormatContext *s, AVPacket *pkt)

读取码流中的音频若干帧或者视频一帧。例如,解码视频的时候,每解码一个视频帧,需要先调用av_read_frame()获得一帧视频的压缩数据,然后才能对该数据进行解码。

AVFormatContext

这个结构体描述了一个媒体文件或媒体流的构成和基本信息。

这是FFMpeg中最为基本的一个结构,是其他所有结构的根,是一个多媒体文件或流的根本抽象。

avformat_alloc_context

分配一个AVFormatContext,使用avformat_free_context来释放分配出来的AVFormatContext。

avformat_open_input

原型

int avformat_open_input(AVFormatContext **ps, const char *url, AVInputFormat *fmt, AVDictionary **options)

打开输出的流和读取头信息。需要使用avformat_close_input关闭打开的流。

avformat_close_input

原型

void avformat_close_input(AVFormatContext **s)

关闭一个打开的输入AVFormatContext,释放它得很所有内容和把指针(*s)置空。

av_dump_format

原型

void av_dump_format(AVFormatContext *ic, int index, const char * url, int is_output)

打印输入或者输出格式的详细信息,比如duration, bitrate, streams, container, programs, metadata, side data, codec and time base。

avformat_new_stream

原型

AVStream* avformat_new_stream(AVFormatContext *s, const AVCodec* c)

添加一个stream到媒体文件中。

avformat_write_header

原型

int avformat_write_header(AVFormatContext *s, AVDictionary ** options)

分配一个stream的私有数据而且写stream的header到一个输出的媒体文件。

AVPixelFormat

像素格式的枚举类型,例如AV_PIX_FMT_YUV420P、AV_PIX_FMT_RGB24

AVMediaType

媒体类型的枚举类型,如AVMEDIA_TYPE_VIDEO(视频)、AVMEDIA_TYPE_AUDIO(音频)、AVMEDIA_TYPE_SUBTITLE(字幕)

avformat_find_stream_info

原型

int avformat_find_stream_info(AVFormatContext *ic, AVDictionary **options)

读取视音频数据来获取一些相关的信息。

av_file_map

原型:

av_file_map(const char *filename, uint8_t **bufptr, size_t * size, int log_offset, void * log_ctx)

读取文件名为filename的文件,并将其内容放入新分配的缓冲区中。

如果成功,则将bufptr设置为读缓冲区或映射缓冲区,并将size设置为*bufptr中缓冲区的字节大小。返回的缓冲区必须使用av_file_unmap()释放。

AVInputFormat

AVInputFormat为FFMPEG的解复用器对象。

AVStream

该结构体描述一个媒体流。

AVCodecParameters

该结构体描述了编码的流的属性。

avcodec_parameters_copy

原型

int avcodec_parameters_copy(AVCodecParameter *dst, const AVCodecParameter* src)

把src中的内容拷贝到dst中。

AVRational

这个结构标识一个分数,num为分数,den为分母。

AVCodecID

解码器标识ID的枚举类型。

swr_alloc

原型

struct SwrContext* swr_alloc(void)

分配一个SwrContext,如果你使用这个函数,需要在调用swr_init()之前设置SwrContext的参数(手工的或者调用swr_alloc_set_opts())

SwrContext

libswresample 的上下文信息。

不像libavcodec和libavformat,这个结构是不透明的,如果你需要设置选项,你必须使用AVOptions而不能直接给这个结构的成员赋值。

swr_alloc_set_opts

原型

struct SwrContext* swr_alloc_set_opts(struct SwrContext *s,

int64_t out_ch_layout,

enum AVSampleFormat out_sample_fmt,

int out_sample_rate,

int64_t in_ch_layout,

enum AVSampleFormat in_sample_fmt,

int in_sample_rate,

int log_offset,

void *log_ctx

)

设置通用的参数,如果SwrContext为空则分配一个SwrContext。

swr_init

原型

init swr_init(struct SwrContext *s)

在参数设置好以后初始化context。

swr_free

原型

void swr_free(struct SwrContext ** s)

释放给定的SwrContext,并且把指针置为空。

sws_getContext

原型

struct SwsContext* sws_getContext ( int srcW,

int srcH,

enum AVPixelFormat srcFormat,

int dstW,

int dstH,

enum AVPixelFormat dstFormat,

int flags,

SwsFilter * srcFilter,

SwsFilter * dstFilter,

const double * param

)

分配和返回一个SwsContext。

avio_open

原型

int avio_open(AVIOContext **s, const char* filename, int flags)

创建和初始化一个AVIOContext用于访问filename指示的资源。

avio_closep

原型

int avio_closep(AVIOContext **s)

关闭AVIOContext** s打开的资源,释放它并且把指针置为空。

AV_ROUND

AV_ROUND_ZERO = 0, // Round toward zero. 趋近于0

AV_ROUND_INF = 1, // Round away from zero. 趋远于0

AV_ROUND_DOWN = 2, // Round toward -infinity. 趋于更小的整数

AV_ROUND_UP = 3, // Round toward +infinity. 趋于更大的整数

AV_ROUND_NEAR_INF = 5, // Round to nearest and halfway cases away from zero.

// 四舍五入,小于0.5取值趋向0,大于0.5取值趋远于0

avio_alloc_context

原型

AVIOContext* avio_alloc_context(unsigned char* buffer,

int buffer_size,

int write_flag,

void* opaque,

int(*)(void *opaque, uint8_t *buf, int buf_size) read_packet,

int(*)(void *opaque, uint8_t *buf, int buf_size) write_packet,

int64_t(*)(void *opaque, int64_t offset, int whence) seek)

分配和初始化一个AVIOContext用于缓冲的I/O。之后需要使用avio_context_free()释放。

av_file_unmap

原型

void av_file_unmap(uint8_t *bufptr, size_t size)

取消映射或释放av_file_map()创建的缓冲区bufptr。

作者:smallest_one

链接:https://www.jianshu.com/p/b6b8c185a617

来源:简书

简书著作权归作者所有,任何形式的转载都请联系作者获得授权并注明出处。

=======================================================

//打开一个封装文件

avformat_open_input(&fmt_ctx, input_filename, NULL, NULL);

//获得封装文件的streamer流信息

avformat_find_stream_info(fmt_ctx, NULL);

//获得封装文件中音频或者视频流的id号

av_find_best_stream(fmt_ctx, AVMEDIA_TYPE_VIDEO, -1, -1, NULL, 0);

//获得音频或视频的codec

pCodecCtx = pFormatCtx->streams[0]->codec;

pCodec = avcodec_find_decoder(pCodecCtx->codec_id); /

origin_par = fmt_ctx->streams[video_stream]->codecpar;

codec = avcodec_find_decoder(origin_par->codec_id);

avcodec_find_encoder(AV_CODEC_ID_FLAC);

//打开codec

avcodec_open2(pCodecCtx, pCodec, NULL);

//根据AVCodec创建AVCodecContext

AVCodecContext* ctx = avcodec_alloc_context3((AVCodec*)enc);

//申请一帧画面的大小

byte_buffer_size = av_image_get_buffer_size(pCodecCtx->pix_fmt, pCodecCtx->width, pCodecCtx->height, 16);

byte_buffer = av_malloc(byte_buffer_size);

//申请音频的大小

byte_buffer_size = av_samples_get_buffer_size(NULL, pCodecCtx->channels, pCodecCtx->sample_rate, pCodecCtx->sample_fmt, 1);

//读取封装文件里的一包数据

av_read_frame(pFormatCtx, &rd_packet);

保存此一包数据(比如h264压缩数据)

fwrite(rd_packet.data, 1, rd_packet.size, video_fp);

//AVPAcket/AVFrame的申请以及初始化操作

av_init_packet(&pkt);

fr = av_frame_alloc();

//解码成yuv的AVFrame

avcodec_decode_video2(ctx, fr, &got_frame, &pkt);

//将AVFrame结构体保存的一帧yuv数据转换成unsigned char*

number_of_written_bytes = av_image_copy_to_buffer(byte_buffer, byte_buffer_size, (const uint8_t* const *)fr->data, (const int*) fr->linesize, ctx->pix_fmt, ctx->width, ctx->height, 1);/

out_frame_bytes = out_frame->nb_samples * out_frame->channels * sizeof(uint16_t);

memcpy(raw_out + out_offset, out_frame->data[0], out_frame_bytes);

out_offset += out_frame_bytes;

//AVFrame中buffer分配的两种方式(只是分配空间)

msg.frame->format = AV_PIX_FMT_RGBA;

msg.frame->width = 320;

msg.frame->height = 240;

ret = av_frame_get_buffer(msg.frame, 32); //int av_frame_get_buffer(AVFrame *frame, int align);

av_frame_get_buffer(in_frame, 32);

int av_image_alloc(uint8_t *pointers[4], int linesizes[4], int w, int h, enum AVPixelFormat pix_fmt, int align);

out_frame = av_frame_alloc();

avcodec_encode_audio2(enc_ctx, &enc_pkt, in_frame, &got_output); //编码

avcodec_decode_audio4(dec_ctx, out_frame, &got_output, &enc_pkt); //解码

//线程相关

av_thread_message_queue_send(wd->queue, &msg, 0);

av_thread_message_queue_recv(rd->queue, &msg, 0);

//FFmpeg进行H.264编码

yuv->pts = vpts;

vpts++;

avcodec_send_frame(vc, yuv);

avcodec_receive_packet(vc, &pack);

//FFmpeg进行视频格式封装和推流

pack.pts = av_rescale_q(pack.pts, vc->time_base, vs->time_base);

pack.dts = av_rescale_q(pack.dts, vc->time_base, vs->time_base);

pack.duration = av_rescale_q(pack.duration, vc->time_base, vs->time_base);

//像素格式转换

sws_getCachedContext()

sws_scale()

///实例介绍

https://linux.cn/article-10932-1.html

//封装格式变换:

ffmpeg -i z.flv -strict -2 z.mp4

ffmpeg -i z.flv -qscale 0 -strict -2 z.avi //-qscale 0 维持你的源视频文件的质量

//视频封装文件保存为音频文件

ffmpeg -i z.flv -vn -ar 44100 -ac 2 -ab 320 -f mp3 output.mp3

ffmpeg -i z.flv -vn(禁止视频) -ar 44100(采样率) -ac(通道数) 2 -ab(比特率) 320 -f(输出文件格式) mp3 output.mp3

//更改视频文件的分辨率

ffmpeg -i z.mp4 -filter:v scale=1280:720 -c:a copy output.mp4

ffmpeg -i input.mp4 -s 1280x720 -c:a copy output.mp4

ffmpeg -i z.mp4 -filter:v(视频过滤器) scale(拉伸过滤器)=1280:720 -c:a copy output.mp4

ffmpeg -i input.mp4 -s(尺寸裁剪) 1280x720 -c:a copy output.mp4

//压缩视频文件

//压缩音频文件(减少通道数,采样率,比特率等)

ffmpeg -i input.mp3 -ab 128 output.mp3

//从封装文件中获取视频流

ffmpeg -i z.mp4 -an video.mp4

//从封装文件中获取音频流

ffmpeg -i z.mp4 -vn audio.mp4

ffmpeg -i z.mp4 -vn -ab 256 -ar 48000 audio.mp3

//从视频中提取图片

ffmpeg -i input.mp4 -r 1 -f image2 image-%2d.png

ffmpeg -i input.mp4 -r(每秒钟提取一张图片(视频30s,则会提取30张图片)) 1 -f image2 image-%2d.png

//裁剪视频

ffmpeg -i input.mp4 -filter:v crop=320:120:200:150 output.mp4

ffmpeg -i input.mp4 -filter:v(视频过滤器) "crop(裁剪过滤器)=w:h:x:y" output.mp4

//转换一个视频的具体的部分(比如从视频开始到指定时间转换为其它格式)

ffmpeg -i input.mp4 -t 10.10 output.avi

ffmpeg -i input.mp4 -t(从视频开始到10s10ms处保存为avi格式) 10.10 output.avi

//使用开始和停止时间剪下一段媒体文件

ffmpeg -i z.mp4 -ss 00:00:10 -codec copy -t 50 output.mp4

ffmpeg -i z.mp4 -ss 00:00:10 -codec copy -t 50 output.avi

//设置视频的屏幕高宽比

ffmpeg -i input.mp4 -aspect 16:9 output.mp4

ffmpeg -i input.mp4 -aspect(设置宽高比) 16:9 output.mp4

//添加海报图像到音频文件

ffmpeg -loop 1 -i image-15.png -i audio.mp3 -c:v libx264 -c:a aac -strict experimental -b:a 192k -shortest output.mp4

ffmpeg -loop 1 -i inputimage.jpg -i inputaudio.mp3 -c:v(指定视频编解码模块) libx264 -c:a((指定音频编解码模块)) aac -strict experimental -b:a(?) 192k -shortest output.mp4

//切分视频文件为多个部分

ffmpeg -i input.mp4 -t 00:00:30 -c copy part1.mp4 -ss 00:00:30 -codec copy part2.mp4 //-c 和 -codec 同一个效果

//接合或合并多个视频部分到一个

ffmpeg -f concat -safe 0 -i join.txt -c copy output.mp4

//添加字幕到一个视频文件

ffmpeg -i input.mp4 -i subtitle.srt -map 0 -map 1 -c copy -c:v libx264 -crf 23 -preset veryfast output.mp4

//增加/减少视频播放速度

ffmpeg -i input.mp4 -vf "setpts=0.5*PTS" output.mp4

//创建动画的 GIF

ffmpeg -ss 00:00:20 -i sample.mp4 -to 10 -r 10 -vf scale=200:-1 cutekid_cry.gif

===================================================================

av_register_all

该函数在所有基于FFmpeg的应用程序中几乎都是第一个被调用的

这个函数把全局的解码器,编码器等结构体注册到一些全局的对象表里,以便后面跑表调用

注册的类型:复用器,解复用器,编码器,解码器,包解析器,BitStreamFilter(位流处理器)等

av_register_all调用了avcodec_register_all,avcodec_register_all注册了和编解码器有关的组件:硬件加速器,解码器,编码器,Parser,Bitstream Filter。av_register_all除了调用avcodec_register_all之外,还注册了复用器,解复用器,协议处理器

下面附上复用器,解复用器,协议处理器的代码

注册复用器的函数是av_register_output_format

注册解复用器的函数是av_register_input_format

注册协议处理器的函数是ffurl_register_protocol

avcodec_register_all()

avcodec_register_all注册了和编解码器有关的组件:硬件加速器,解码器,编码器,Parser,Bitstream Filter。

硬件加速器注册函数:av_register_hwaccel()

编码器注册函数:avcodec_register()

parser注册函数:av_register_parser()

Bitstream Filter注册函数:av_register_bitstream_filter()

内存的分配和释放

内存操作的几个常见函数位于 libavutil\mem.c

先说下size_t,这个类型在FFmpeg中多次出现,它的作用其实就是为了增强程序的可移植性而定义的,不同系统上,定义size_t可能不一样,它实际上就是unsigned int

为什么要内存对齐:内存对齐是什么就不说了,c语言的,很多也有点忘记了,直接看结论吧:内存不对齐对cpu对性能是有影响的

av_malloc()

源码也自己去看,除去源码中一大推宏类似于CONFIG_MEMORY_POISONING,因为这个宏默认都是为0的,源码函数可精简为

void *av_malloc(size_t size)

{

void *ptr = NULL;

/* let's disallow possibly ambiguous cases */

if (size > (max_alloc_size - 32))

return NULL;

ptr = malloc(size);

if(!ptr && !size) {

size = 1;

ptr= av_malloc(1);

}

return ptr;

所以可以看出来,av_malloc()只是封装了系统的malloc(),并且做了一些错误检查的工作

av_realloc

用于对申请的内存的大小进行调整

跟av_malloc()一样,除去没用的宏,精简为

void *av_realloc(void *ptr, size_t size)

{

/* let's disallow possibly ambiguous cases */

if (size > (max_alloc_size - 32))

return NULL;

return realloc(ptr, size + !size);

}

可以看出来,av_realloc()其实就是封装系统的realloc()

av_mallocz()

av_mallocz()可以理解为av_mallocz()+zeromemory

精简后

void *av_mallocz(size_t size)

{

void *ptr = av_malloc(size);

if (ptr)

memset(ptr, 0, size);

return ptr;

}

可以看出来就是调用了av_malloc(size)之后,又调用memset()将分配的内存设置为0

av_calloc()

它是简单的封装了av_mallocz()

void *av_calloc(size_t nmemb, size_t size)

{

if (size <= 0 || nmemb >= INT_MAX / size)

return NULL;

return av_mallocz(nmemb * size);

}

从代码中可以看出,它调用av_mallocz()分配了nmemb * size个字节的内存

av_free()

用于释放申请的内存,除去没用的宏之外,代码如下

void av_free(void *ptr)

{

free(ptr);

}

就是封装了free()

av_freep()

简单了封装了av_free(),并且在释放内存之后将目标指针设置为NULL

void av_freep(void *arg)

{

void **ptr = (void **)arg;

av_free(*ptr);

*ptr = NULL;

}

FFmpeg典型代码例子

//视频解码

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <libavcodec/avcodec.h>

#define INBUF_SIZE 4096

static void pgm_save(unsigned char *buf, int wrap, int xsize, int ysize,

char *filename)

{

FILE *f;

int i;

f = fopen(filename,"w");

fprintf(f, "P5\n%d %d\n%d\n", xsize, ysize, 255);

for (i = 0; i < ysize; i++)

fwrite(buf + i * wrap, 1, xsize, f);

fclose(f);

}

static void decode(AVCodecContext *dec_ctx, AVFrame *frame, AVPacket *pkt,

const char *filename)

{

char buf[1024];

int ret;

ret = avcodec_send_packet(dec_ctx, pkt);

if (ret < 0) {

fprintf(stderr, "Error sending a packet for decoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_frame(dec_ctx, frame);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during decoding\n");

exit(1);

}

printf("saving frame %3d\n", dec_ctx->frame_number);

fflush(stdout);

/* the picture is allocated by the decoder. no need to

free it */

snprintf(buf, sizeof(buf), "%s-%d", filename, dec_ctx->frame_number);

pgm_save(frame->data[0], frame->linesize[0],

frame->width, frame->height, buf);

}

}

int main(int argc, char **argv)

{

const char *filename, *outfilename;

const AVCodec *codec;

AVCodecParserContext *parser;

AVCodecContext *c= NULL;

FILE *f;

AVFrame *frame;

uint8_t inbuf[INBUF_SIZE + AV_INPUT_BUFFER_PADDING_SIZE];

uint8_t *data;

size_t data_size;

int ret;

AVPacket *pkt;

if (argc <= 2) {

fprintf(stderr, "Usage: %s <input file> <output file>\n"

"And check your input file is encoded by mpeg1video please.\n", argv[0]);

exit(0);

}

filename = argv[1];

outfilename = argv[2];

pkt = av_packet_alloc();

if (!pkt)

exit(1);

/* set end of buffer to 0 (this ensures that no overreading happens for damaged MPEG streams) */

memset(inbuf + INBUF_SIZE, 0, AV_INPUT_BUFFER_PADDING_SIZE);

/* find the MPEG-1 video decoder */

codec = avcodec_find_decoder(AV_CODEC_ID_MPEG1VIDEO);

if (!codec) {

fprintf(stderr, "Codec not found\n");

exit(1);

}

parser = av_parser_init(codec->id);

if (!parser) {

fprintf(stderr, "parser not found\n");

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate video codec context\n");

exit(1);

}

/* For some codecs, such as msmpeg4 and mpeg4, width and height

MUST be initialized there because this information is not

available in the bitstream. */

/* open it */

if (avcodec_open2(c, codec, NULL) < 0) {

fprintf(stderr, "Could not open codec\n");

exit(1);

}

f = fopen(filename, "rb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

frame = av_frame_alloc();

if (!frame) {

fprintf(stderr, "Could not allocate video frame\n");

exit(1);

}

while (!feof(f)) {

/* read raw data from the input file */

data_size = fread(inbuf, 1, INBUF_SIZE, f);

if (!data_size)

break;

/* use the parser to split the data into frames */

data = inbuf;

while (data_size > 0) {

ret = av_parser_parse2(parser, c, &pkt->data, &pkt->size,

data, data_size, AV_NOPTS_VALUE, AV_NOPTS_VALUE, 0);

if (ret < 0) {

fprintf(stderr, "Error while parsing\n");

exit(1);

}

data += ret;

data_size -= ret;

if (pkt->size)

decode(c, frame, pkt, outfilename);

}

}

/* flush the decoder */

decode(c, frame, NULL, outfilename);

fclose(f);

av_parser_close(parser);

avcodec_free_context(&c);

av_frame_free(&frame);

av_packet_free(&pkt);

return 0;

}

//视频压缩

#include <stdio.h>

#include <stdlib.h>

#include <string.h>

#include <libavcodec/avcodec.h>

#include <libavutil/opt.h>

#include <libavutil/imgutils.h>

static void encode(AVCodecContext *enc_ctx, AVFrame *frame, AVPacket *pkt,

FILE *outfile)

{

int ret;

/* send the frame to the encoder */

if (frame)

printf("Send frame %3"PRId64"\n", frame->pts);

ret = avcodec_send_frame(enc_ctx, frame);

if (ret < 0) {

fprintf(stderr, "Error sending a frame for encoding\n");

exit(1);

}

while (ret >= 0) {

ret = avcodec_receive_packet(enc_ctx, pkt);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF)

return;

else if (ret < 0) {

fprintf(stderr, "Error during encoding\n");

exit(1);

}

printf("Write packet %3"PRId64" (size=%5d)\n", pkt->pts, pkt->size);

fwrite(pkt->data, 1, pkt->size, outfile);

av_packet_unref(pkt);

}

}

int main(int argc, char **argv)

{

const char *filename, *codec_name;

const AVCodec *codec;

AVCodecContext *c= NULL;

int i, ret, x, y;

FILE *f;

AVFrame *frame;

AVPacket *pkt;

uint8_t endcode[] = { 0, 0, 1, 0xb7 };

if (argc <= 2) {

fprintf(stderr, "Usage: %s <output file> <codec name>\n", argv[0]);

exit(0);

}

filename = argv[1];

codec_name = argv[2];

/* find the mpeg1video encoder */

codec = avcodec_find_encoder_by_name(codec_name);

if (!codec) {

fprintf(stderr, "Codec '%s' not found\n", codec_name);

exit(1);

}

c = avcodec_alloc_context3(codec);

if (!c) {

fprintf(stderr, "Could not allocate video codec context\n");

exit(1);

}

pkt = av_packet_alloc();

if (!pkt)

exit(1);

/* put sample parameters */

c->bit_rate = 400000;

/* resolution must be a multiple of two */

c->width = 352;

c->height = 288;

/* frames per second */

c->time_base = (AVRational){1, 25};

c->framerate = (AVRational){25, 1};

/* emit one intra frame every ten frames

* check frame pict_type before passing frame

* to encoder, if frame->pict_type is AV_PICTURE_TYPE_I

* then gop_size is ignored and the output of encoder

* will always be I frame irrespective to gop_size

*/

c->gop_size = 10;

c->max_b_frames = 1;

c->pix_fmt = AV_PIX_FMT_YUV420P;

if (codec->id == AV_CODEC_ID_H264)

av_opt_set(c->priv_data, "preset", "slow", 0);

/* open it */

ret = avcodec_open2(c, codec, NULL);

if (ret < 0) {

fprintf(stderr, "Could not open codec: %s\n", av_err2str(ret));

exit(1);

}

f = fopen(filename, "wb");

if (!f) {

fprintf(stderr, "Could not open %s\n", filename);

exit(1);

}

frame = av_frame_alloc();

if (!frame) {

fprintf(stderr, "Could not allocate video frame\n");

exit(1);

}

frame->format = c->pix_fmt;

frame->width = c->width;

frame->height = c->height;

ret = av_frame_get_buffer(frame, 32);

if (ret < 0) {

fprintf(stderr, "Could not allocate the video frame data\n");

exit(1);

}

/* encode 1 second of video */

for (i = 0; i < 25; i++) {

fflush(stdout);

/* make sure the frame data is writable */

ret = av_frame_make_writable(frame);

if (ret < 0)